Deep Learning คืออะไร ? ทำงานอย่างไร ? เกี่ยวข้องกับ AI อย่างไรบ้าง ?

moonlightkz

moonlightkzDeep Learning คืออะไร ?

บางคนที่สนใจในเทคโนโลยี AI น่าจะเคยได้ยิน Buzzword เกี่ยวกับ AI มาแล้วอยู่หลายคำ อาจรู้ถึงด้วยว่ามีอัลกอริทึมที่ เทคโนโลยีปัญญาประดิษฐ์ (AI) ใช้ในการทำงานอยู่หลายตัว เทคโนโลยีที่อยู่เบื้องหลังนวัตกรรมใหม่ ๆ ที่เราใช้งานกันอยู่ในชีวิตประจำวัน เช่น ทำไม Netflix, Spotify หรือ YouTube สามารถแนะนำเนื้อหาใหม่ที่คุณเห็นแล้วรู้สึกว่ามันช่างโดนใจได้อย่างแม่นยำ ? หรือทำไม ChatGPT ถึงตอบคำถามได้ฉลาดมาก ? คำตอบคือ Deep Learning

- Node ใน AI คืออะไร ? สำคัญกับโมเดลของ AI อย่างไร ?

- TensorFlow คืออะไร ? รู้จักแพลตฟอร์ม เพื่อการพัฒนา Machine Learning จาก Google

- Neural Network คืออะไร ? รู้จักเครือข่ายประสาทเทียม เทคโนโลยีเบื้องหลัง AI

- Few-Shot Learning คืออะไร ? รู้จักเทคนิค AI ที่เรียนรู้ได้จากข้อมูลเพียงไม่กี่ตัว

- Image Recognition คืออะไร ? มาเข้าใจหลักการที่คอมพิวเตอร์ "จดจำภาพ" กัน

มนุษย์เป็นสิ่งมีชีวิตที่เรียนรู้จากประสบการณ์ ยิ่งมีประสบการณ์มากเท่าไหร่ ? เราก็สามารถเรียนรู้ได้มากเท่านั้น สำหรับ AI ก็มีกระบวนการเรียนรู้ที่เหมือนกัน มันถูกเรียกว่า "Deep Learning" โดยประสบการณ์ที่เครื่องจักรสามารถเรียนรู้จะได้รับมาจากข้อมูลที่เราป้อนเข้าไป ปริมาณ และคุณภาพของข้อมูลที่มันได้รับ จะสะท้อนกลับมาเป็นความฉลาดของ AI

เรามีบทความแนะนำเกี่ยวกับ เทคโนโลยี AI และ การเรียนรู้ของเครื่องจักร (Machine Learning) ไปแล้ว ก็ถึงคราวหัวข้อ Deep Learning กันบ้าง ...

การเรียนรู้เชิงลึก คืออะไร ? (What is Deep Learning ?)

ในระบบแบบดั้งเดิมนั้น Machine Learning จะทำงานโดยพึ่งพาอัลกอริทึมเป็นหลัก ซึ่งวิธีดังกล่าวมีข้อเสียตรงที่ ไม่ว่าเราจะป้อนข้อมูลเข้าไปจำนวนมากขนาดไหนก็ตาม แต่ความฉลาดที่อัลกอริทึมสามารถทำได้ก็มีเพดานที่จำกัด แต่ในที่สุดนักวิทยาศาสตร์ก็หาวิธีทลายเพดานดังกล่าวลงได้ นั่นคือการใช้เทคนิค Deep Learning

Deep Learning สามารถปรับปรุงประสิทธิภาพให้ระบบมีฉลาดขึ้นได้ หากมันสามารถเข้าถึงข้อมูลได้มากขึ้น และสั่งสมประสบการณ์ผ่านกระบวนการ Deep Learning จนชำนาญ เราสามารถนำมันมาใช้งานที่ต้องอาศัยความชำนาญเฉพาะทางได้ ตัวอย่างเช่น ระบบขับรถอัตโนมัติ, ตรวจหาวัชพืชในระบบเกษตรกรรม, ตรวจหาเซลล์มะเร็ง ฯลฯ

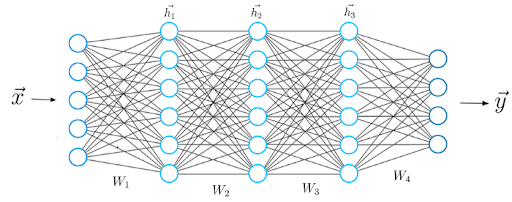

การเรียนรู้ของ Deep Learning สามารถทำงานร่วมกับข้อมูลหลากหลายประเภท ไม่ว่าจะเป็นรูปภาพ, ข้อความ หรือเสียง ตามปกติแล้ว Deep Learning จะทำงานด้วยโครงสร้างสถาปัตยกรรม Neural Network (โครงข่ายประสาทเทียม) เหตุผลที่มันใช้คำว่า "Deep" (ลึก) ก็มาจากการที่มันมี Layers ของ Neural Network อยู่เป็นจำนวนมาก

หากยังจำกันได้ในบทความ Machine Learning ในช่วงปี ค.ศ. 1960 (พ.ศ. 2503) นักวิทยาศาสตร์ได้ค้นพบว่า หากเพิ่มชั้น Neural Network จากเดิมที่มีอยู่ชั้นเดียว ให้เป็น 2-3 ชั้น หรือที่เรียกว่า Multilayer จะส่งผล การทำงานของ Machine Learning มีประสิทธิภาพสูงขึ้นกว่าเดิมมาก แต่ในระบบ Deep Learning นั้น สามารถมีได้มากกว่า 100 ชั้น

โดย Deep Learning จัดเป็นสาขาย่อยของ Machine Learning ที่ต้องการพัฒนาระบบอัลกอริทึมโดยอ้างอิงการทำงานจากโครงสร้าง และการทำงานของสมองมนุษย์ นั่นเป็นเหตุผลว่าทำไม Deep Learning ถึงถูกเรียกว่า "Artificial neural Networks" (โครงสร้างประสาทเทียม)

การเรียนรู้เชิงลึก ทำงานอย่างไร ? (How does Deep Learning work ?)

อัลกอริทึมที่ใช้ใน Deep Learning ถูกออกแบบมาให้พยายามหาคำตอบ ด้วยการเลียนแบบรูปแบบการทำงานของสมองมนุษย์ ที่มีการวิเคราะห์เหตุผลเชิงตรรกะเพื่อหาคำตอบ ซึ่งการจะทำแบบนี้ได้ ระบบ Deep Learning จำเป็นต้องมีโครงข่ายอัลกอริทึมประสาทเทียม (Neural Network) จำนวนหลายชั้น

Neural Network ถูกออกแบบขึ้นมาโดยอ้างอิงจากโครงสร้างสมองมนุษย์ เราใช้สมองในการจำแนก และจัดกลุ่มข้อมูลชนิดต่าง ๆ ซึ่งเราสามารถสอนให้ Neural Network ทำงานกับข้อมูล ด้วยวิธีการเดียวกับสมองของเราได้

ภาพจาก : https://builtin.com/machine-Learning/deep-Learning

แต่ละ Layers ที่มีอยู่ใน Neural Networks จะทำหน้าที่ในการกลั่นกรองข้อมูลตั้งแต่ขั้นเริ่มต้นที่เป็นการกรองแบบหยาบ ๆ ไล่ไปจนถึงขั้นสุดท้ายที่จะเจาะลึกลงในรายละเอียด ซึ่งสมองของเราก็ทำงานในลักษณะเช่นนั้น เวลาที่สมองได้รับข้อมูลใหม่เข้ามา สมองจะพยายามนำข้อมูลดังกล่าวไปเปรียบเทียบ กับข้อมูลที่เรารู้จักก่อนเสมอ

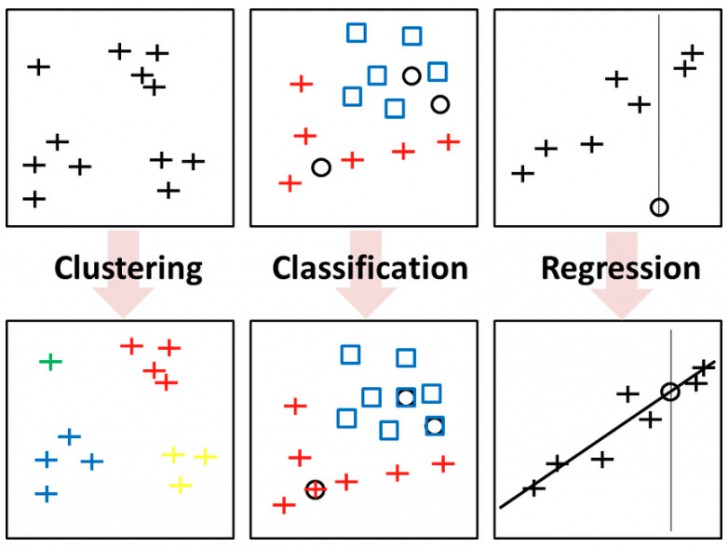

พื้นฐานการทำงานของ Neural Network จะมีอยู่หลัก ๆ อยู่ 3 ส่วน คือ จัดกลุ่ม (Clustering), จำแนกประเภท (Classication) และหาความสัมพันธ์ (Regression) เมื่อทั้งหมดทำงานร่วมกัน ทำให้ Neural Network สามารถรับมือกับข้อมูลใหม่ที่ไม่เคยรู้จักมาก่อนได้อย่างชาญฉลาด

ภาพจาก : https://www.researchgate.net/figure/The-three-pillars-of-Learning-in-data-science-clustering-flat-or-hierarchical_fig1_314626729

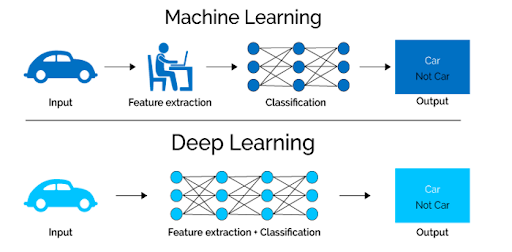

ถ้ามองที่ความแตกต่าง งานแบบที่ Machine Learning ดั้งเดิมทำได้ ตัว Neural Network ก็สามารถทำได้ แต่งานที่ Neural Network ทำได้ ตัว Machine Learning ดั้งเดิม จะไม่สามารถทำได้

เหตุผลก็มาจากคุณสมบัติของ Deep Learning ใน Neural Network ที่สามารถนำข้อมูลใหม่มาวิเคราะห์, เปรียบเทียบ, หาความสัมพันธ์ และหาคำตอบได้ ส่งผลให้เมื่อเจอปัญหาใหม่ที่ไม่รู้จัก ก็ยังคิดหาคำตอบออกมาได้นั่นเอง โดย ขั้นตอนการทำงานของ Deep Learning สามารถแบ่งออกเป็น 5 ขั้นตอน ได้ดังนี้

- ทำความเข้าใจปัญหา

- ระบุรูปแบบข้อมูล

- เลือกอัลกอริทึม Deep Learning ที่เหมาะสม

- นำข้อมูลมาให้โมเดลฝึกฝน

- ทดสอบการทำงานของโมเดล

ภาพจาก : https://builtin.com/machine-Learning/deep-Learning

ประเภทของ Deep Learning

Deep Learning มีอยู่หลายชนิด โดยจะแบ่งด้วยรูปแบบการทำงานของโมเดลที่มีความแตกต่างกัน ตัวอย่างโมเดล Deep Learning ที่ได้รับความนิยมจะมีอยู่ 3 ชนิด ประกอบไปด้วย

Convolutional Neural Networks (CNNs)

เป็นโมเดล Deep Learning ที่ออกแบบมาเพื่อประมวลผลรูปภาพ โมเดลนี้ได้แรงบันดาลใจมาจากกระบวนการมองเห็นของมนุษย์ ซึ่งสายตาของมนุษย์จะมีการรับรู้ภาพที่สามารถระบุลักษณะเฉพาะของภาพได้ ไม่ว่าจะเป็นขอบ, มุม, สี, รูปทรง ฯลฯ

Convolutional neural Networks (CNNs) ถูกนำมาใช้ประโยชน์ในงานด้าน Computer vision อย่าง การตรวจจับวัตถุ และการจดจำใบหน้า

Deep Reinforcement Learning (DRL)

เป็นการผสมผสานรูปแบบการทำงานของ Deep Learning และ Reinforcement Learning (RL) เข้าด้วยกัน เพื่อสร้างระบบที่สามารถเรียนรู้จากการปฏิสัมพันธ์ กับสภาพแวดล้อม และทำการตัดสินใจเมื่อพบกับเหตุการณ์ใหม่ที่ไม่เคยเจอมาก่อนได้ โดย RL เป็นวิธีการเรียนรู้ด้วยการจำลอง "ตุ๊กตา" (Agent) ขึ้นมาลองผิดลองถูก แล้วระบบจะให้ประเมินผลลัพธ์เพื่อให้คะแนน หากผลลัพธ์ออกมาดี ก็จะมีการเรียนรู้ที่จะตัดสินใจในแนวทางนั้นเพิ่มมากขึ้น

ด้วยคุณสมบัติเช่นนี้ Deep reinforcement Learning (DRL) จึงเหมาะสมกับการใช้ในการพัฒนาหุ่นยนต์ และใช้กับ Non-player character (NPC) ในเกมคอมพิวเตอร์

Recurrent Neural Networks (RNNs)

เป็นโมเดลที่ออกแบบมาเพื่อรับมือกับข้อมูลที่มีรูปแบบลำดับ หรือเวลาเป็นองค์ประกอบหลักอย่างชัดเจน เช่น ข้อความ หรือภาษา ที่จะมีไวยากรณ์เป็นตัวกำหนดลำดับ เนื่องจาก Recurrent neural Networks (RNNs) จะจดจำสถานะของข้อมูลก่อนหน้า เพื่อนำรูปแบบมาใช้ในการคำนวณหาค่าข้อมูลปัจจุบัน ซึ่งทำให้มันเหมาะสำหรับงานที่ต้องการความเข้าใจเกี่ยวกับ ความสัมพันธ์เชิงลำดับ

อย่างไรก็ตาม Recurrent neural Networks (RNNs) มีข้อจำกัดในกรณีที่ความสัมพันธ์ของข้อมูลมีระยะห่างไกลกันเกินไป ภายหลังจึงมีการคิดโมเดลใหม่ที่มีความซับซ้อนขึ้นเพื่อนำมาใช้แก้ไขปัญหานี้ เช่น Long Short-Term Memory (LSTM) และ Gated Recurrent Unit (GRU)

Recurrent neural Networks (RNNs) นิยมใช้ในเทคโนโลยี Natural Language Processing (NLP) ซึ่งเป็นสาขาย่อยของ Artificial intelligence (AI) ที่พัฒนาการสื่อสารระหว่างมนุษย์ และคอมพิวเตอร์ ให้สามารถสื่อสารเข้าใจกันได้ ระบบแปลภาษา, จดจำเสียงพูด หรือคาดการณ์ความน่าจะเป็นของเหตุการณ์ในอนาคตอันใกล้

การเรียนรู้เชิงลึก กับ ปัญญาประดิษฐ์ มีความเกี่ยวข้องกันอย่างไร ? (How Deep Learning and Artificial Intelligence are related ?)

อันที่จริงแล้ว Deep Learning ทำงานร่วมกับ AI อยู่หลายตัว มันช่วยให้แอปพลิเคชัน และบริการต่าง ๆ ที่มีระบบ AI สามารถทำงานได้อย่างชาญฉลาด โดยเข้ามาช่วยในส่วนการวิเคราะห์ และควบคุมให้ทำงานได้โดยไม่ต้องพึ่งพาการสั่งงานจากมนุษย์

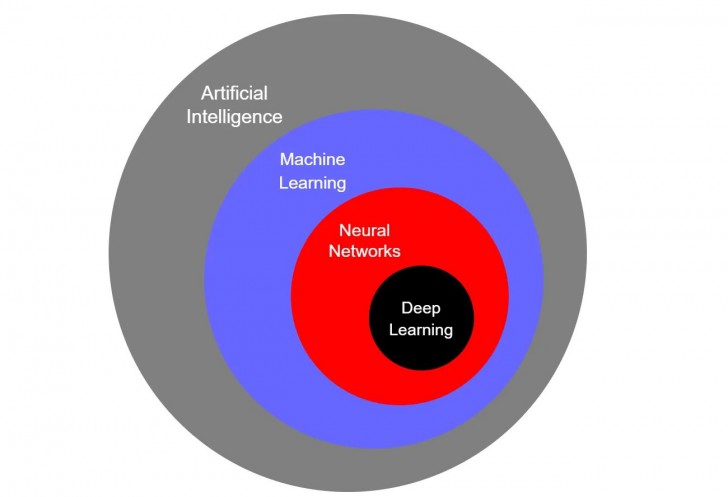

Deep Learning เป็นหนึ่งในเทคนิคที่ซับซ้อนของ Machine Learning ที่มีคุณสมบัติช่วยให้คอมพิวเตอร์เข้าใจ และตอบสนองสิ่งที่มนุษย์ต้องการได้อย่างเป็นธรรมชาติ นวัตกรรมรถยนต์ไร้คนขับ, ผู้ช่วยอัจฉริยะ, Generative AI ฯลฯ ที่เราใช้งานกันอยู่ในปัจจุบันนี้ ล้วนแต่มี Deep Learning อยู่เบื้องหลังทั้งนั้น

สรุปโดยสังเขป Deep Learning ทำงานด้วยโครงสร้าง Neural Network ของ Machine Learning ที่อยู่ภายใต้ AI นั่นเอง

ภาพจาก : https://medium.com/data-science-365/the-relationship-between-ai-ml-nns-and-dl-60bd40069908

ประวัติความเป็นมาของ การเรียนรู้เชิงลึก (History of Deep Learning)

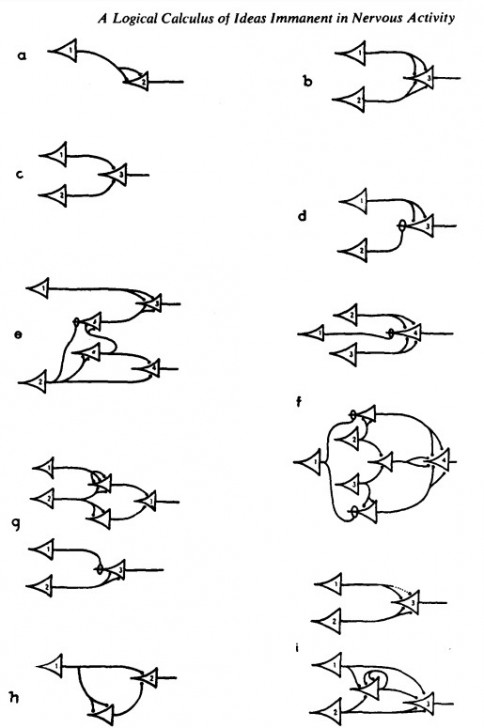

ร่องรอยการพัฒนา Deep Learning สามารถย้อนกลับไปได้ถึงปี ค.ศ. 1943 (พ.ศ. 2486) โดย Walter Pitts นักประสาทวิทยา และไซเบอร์เนติกส์ (Cybernetics) ร่วมกับ Warren McCulloch นักตรรกศาสตร์ และนักจิตวิทยา ได้เสนอแนวคิดคอมพิวเตอร์ที่มีหลักการทำงานเหมือนกับระบบประสาท (Neural Network) ของสมองมนุษย์

พวกเขานำหลักอัลกอริทึม และคณิตศาสตร์ มาทำงานร่วมกันเพื่อจำลองกระบวนการคิดของสมอง เรียกว่า "Threshold Logic" มันได้รับการยกย่องว่าเป็นอัลกอริทึม Neural Network ตัวแรกของโลก

ภาพจาก : https://www.cse.chalmers.se/~coquand/AUTOMATA/mcp.pdf

ค.ศ. 1960 (พ.ศ. 2503) - โมเดล Backpropagation

Henry J. Kelley เป็นศาสตราจารย์ด้านวิศวกรรมการบิน, อวกาศ และมหาสมุทร จากสถาบันโปลีเทคนิคเวอร์จิเนีย เขาได้คิดค้นทฤษฏีหลายอย่างที่เป็นประโยชน์ต่อมนุษยชาติขึ้นมาหลายอย่าง หนึ่งในนั้นคือ โมเดล Backpropagation ซึ่งเป็นกระบวนการที่ใช้ในการปรับน้ำหนักค่าผลลัพธ์ เพื่อลดความแตกต่างระหว่างค่าที่คาดการณ์ กับค่าจริง ช่วยให้โมเดล Neural Network สามารถปรับปรุง และเรียนรู้จากข้อมูลได้

ค.ศ. 1979 (พ.ศ. 2522) - กำเนิดโมเดล Neocognitron

ในช่วงยุค 70 ถือเป็นช่วงเวลาที่เลวร้ายของการวิจัยเทคโนโลยี Artificial intelligence (AI) เนื่องจากความคืบหน้าเป็นไปอย่างล่าช้า และไม่มีความสำเร็จที่จับต้องได้ ส่งผลให้นักลงทุนถอนตัวกันไปหลายราย แต่โชคดีที่ยังมีนักวิจัยบางคนไม่ย่อท้อ เขายังคงทุ่มเทวิจัยต่อไปแม้จะไม่มีเงินสนับสนุนแล้วก็ตาม

Kunihiko Fukushima นักวิทยาศาสตร์คอมพิวเตอร์ชาวญี่ปุ่น ได้เผยแพร่งานวิจัย "Neocognitron" มันเป็นโมเดลที่สามารถแยกแยะลายมือภาษาญี่ปุ่น และรูปแบบได้ ส่งผลให้คอมพิวเตอร์สามารถ "เรียนรู้" วิธีแยกแยะข้อมูลรูปภาพได้

หลักการทำงานของโมเดล Neocognitron คือ เมื่อมีข้อมูลมากกว่าหนึ่งรูปแบบ ข้อมูลดังกล่าวจะถูกแยกออกไปวิเคราะห์เพื่อจดจำรูปแบบ ทำแบบนี้จนไม่เหลือข้อมูลซ้ำกัน ท้ายที่สุดแล้วมันก็จะสามารถแยกแยะข้อมูลทุกรูปแบบที่มีอยู่ได้

แนวคิดของ Neocognitron เป็นแรงบันดาลใจให้เกิดโมเดลใหม่ ๆ ขึ้นมาอีกหลายตัว โมเดล Convolutional neural Networks (CNNs) ก็ได้แรงบันดาลใจมาเช่นกัน

ภาพจาก : http://www.scholarpedia.org/article/Neocognitron

ค.ศ. 1980-1990 (พ.ศ. 2532-2542) - Backpropagation และ GPU

Yann LeCun นักวิทยาการคอมพิวเตอร์ชาวฝรั่งเศส หนึ่งในผู้ที่มีส่วนร่วมในการพัฒนาโมเดล Convolutional neural Networks (CNNs) ได้ประสบความสำเร็จในการสาธิตการทำงานของโมเดล Backpropagation เป็นครั้งแรก ซึ่งเป็นโมเดลที่ช่วยลดความแตกต่างระหว่างค่าที่คาดการณ์ และค่าจริงได้ มันช่วยให้ Machine Learning ทำงานได้แม่นยำ

อย่างไรก็ตาม ในช่วงเวลาเดียวกันนี้ ก็ถือเป็นยุคมืดของวงการ AI อีกครั้ง ซึ่งมันได้ส่งผลกระทบต่อนักวิจัย Neural Networks และ Deep Learning เป็นอย่างมาก โดยสาเหตุเกิดจากการที่มี "นักวิจัยบางราย" ได้ขี้โม้โอ้อวดความสำเร็จเกินกว่าความเป็นจริงไปหลายเท่า ส่งผลให้นักลงทุนเกิดความคาดหวัง และเพิ่มเงินลงทุนให้มากกว่าเดิม แต่ท้ายที่สุดแล้วกลับไม่ได้อะไรตอบแทน เพราะทุกอย่างเป็นเรื่องโกหกตั้งแต่แรกเริ่ม

อย่างไรก็ตาม โชคดีที่ยังมีนักวิจัยที่ทุ่มเทแรงกายแรงใจ หาทางพัฒนา AI และ Deep Learning ด้วยความจริงใจอยู่บ้าง มีงานวิจัยหลายชิ้นที่ทำให้วงการมีความก้าวกระโดดขึ้นในช่วงนี้ด้วยเช่นกัน อย่าง โมเดล Long-short-term memory (LTSM) ที่จำเป็นต่อการทำงานของโมเดล Recurrent neural Networks (RNNs) ก็ถูกพัฒนาขึ้นในปี ค.ศ. 1997 (พ.ศ. 2540)

นอกจากนี้ ในช่วงปี ค.ศ. 1999 (พ.ศ. 2542) ฮาร์ดแวร์ของคอมพิวเตอร์ก็มีประสิทธิภาพสูงขึ้น จากการที่มี หน่วยประมวลผลกลาง (CPU) ที่ดีขึ้น และมีการพัฒนา หน่วยประมวลผลกราฟิก (GPU) ขึ้นมาด้วย และด้วยความสามารถของ GPU นั้น จึงช่วยให้การคำนวณของ Neural Network ในเวลานั้น เร็วขึ้นกว่าเดิมถึง 1,000 เท่า ซึ่งช่วยให้การวิจัยคืบหน้าไปได้เร็วกว่าเดิมมาก

ค.ศ. 2000-2010 (พ.ศ. 2543-2553)

มีการค้นพบปัญหาที่ถูกเรียกว่า "Vanishing Gradient Problem" โดยมันไม่ได้เกิดขึ้นกับ Neural Network ทุกโมเดล แต่จะมีผลแค่โมเดลที่ใช้เทคนิค Gradient-Based Learning Methods เท่านั้น อาการคือข้อมูลที่อยู่ใน Layer ชั้นต่ำกว่า จะไม่ถูกส่งไปให้ Layer ที่อยู่ชั้นสูงกว่าได้เรียนรู้ต่อ

โดยสาเหตุมาจากการที่คำตอบที่ Layer ชั้นล่างคำนวณค่าออกมาได้ มีความแตกต่างกันน้อยเกินไปจน Layer ชั้นบน ทำการจัดกลุ่มคำตอบให้มันเป็นค่าเดียวกัน ปัญหานี้ได้นำไปสู่การแก้ปัญหา จนพัฒนาออกมาเป็นเทคนิคใหม่ ๆ ในภายหลัง

ในปี ค.ศ. 2001 (พ.ศ. 2544) META Group (ปัจจุบันนี้คือ Gartner) ได้เผยแพร่รายงานว่าปริมาณข้อมูลดิจิทัลกำลังขยายตัวอย่างรวดเร็ว ทั้งแหล่งข้อมูล และรูปแบบข้อมูลกำลังเพิ่มขึ้นด้วยความเร็วสูง Big Data กำลังถือกำเนิดขึ้น

ในปี ค.ศ. 2009 (พ.ศ. 2552) Fei-Fei LI ศาสตราจารย์ด้าน AI จากมหาวิทยาลัยสแตนฟอร์ด (Stanford University) ได้เปิดตัว ImageNet มันเป็นฐานข้อมูลรูปภาพขนาดใหญ่ มีรูปภาพมากกว่า 14 ล้านรูป ที่ผ่านการจัดระเบียบข้อมูลเป็นที่เรียบร้อยแล้ว เขาคาดหวังว่ารูปภาพเหล่านี้จะช่วยให้การพัฒนา Neural Network ก้าวไปข้างหน้าได้ไวยิ่งขึ้น

ค.ศ. 2011-ปัจจุบัน (พ.ศ. 2554-ปัจจุบัน)

ในปี ค.ศ. 2011 (พ.ศ. 2554) การพัฒนาของ GPU มีประสิทธิภาพแรงขึ้นอย่างก้าวกระโดด ส่งผลให้สามารถพัฒนา Neural Networks ที่สามารถประมวลผลข้อมูลใหม่ ๆ ได้แบบเรียลไทม์ โดยไม่ต้องใช้การฝึกฝนล่วงหน้าเหมือนในอดีต

ถัดมาในปี ค.ศ. 2012 (พ.ศ. 2555) Google Brain ได้เปิดตัวโครงการสุดน่ารัก ที่รู้จักกันในชื่อ "The Cat Experiment" มันเป็นโครงการ Neural Network ที่สามารถค้นหา "แมว" จากอินเทอร์เน็ตได้ ซึ่งเบื้องหลังการทำงานของมันต้องใช้โมเดลหลายตัวในการค้นหาคำตอบ

การค้นพบที่น่าสนใจเกิดขึ้นอีกครั้งใน ปี ค.ศ. 2014 (พ.ศ. 2557) ด้วยความอัจฉริยะของ Ian Goodfellow เขาได้พัฒนาเทคนิค Generative Adversarial Neural Network (GAN) ขึ้นมา หลักการง่าย ๆ คือ สร้าง Neural Network ขึ้นมาสอง ตัว แล้วให้พวกมันเล่นเกมจับผิดกันเอง ว่าใครจะหลอกได้เนียนกว่ากัน เทคนิคนี้ทำให้การพัฒนา AI มีประสิทธิภาพสูงกว่าเดิมมาก

บทสรุปของ การเรียนรู้เชิงลึก (Deep Learning Conclusions)

ในปัจจุบันนีั สถานการณ์ของ เทคโนโลยี AI ก็ยังคงพึ่งพา Deep Learning เป็นหลัก และตัว Deep Learning เองก็ยังคงเป็นเทคโนโลยีที่ยังสามารถพัฒนาได้อีกไกล

เราเห็นหลายบริษัทเปิดตัวผลิตภัณฑ์ด้าน AI ที่น่าทึ่งออกมามากมาย แม้มันจะช่วยยกระดับชีวิตประจำวันของมนุษย์ให้ดีขึ้นได้ แต่หลายฝ่ายก็กังวลกับผลกระทบที่อาจเกิดขึ้นได้ ไม่ว่าจะในแง่จริยธรรม หรือเศรษฐกิจ

แต่ไม่ว่าจะอย่างไรก็ตาม มันเป็นเทคโนโลยีที่มาแน่นอน เมื่อถึงวันนั้น โลกของเราจะแตกต่างจากปัจจุบันนี้อย่างแน่นอน

ที่มา : kenovy.com , www.forbes.com , datascientest.com , builtin.com , www.datacamp.com , www.mckinsey.com , www.netapp.com , www.mathworks.com , www.cloudflare.com , www.simplilearn.com , www.coursera.org , cloud.google.com , en.wikipedia.org , www.ibm.com , www.dataversity.net , www.historyofinformation.com

คำสำคัญ »

คำสำคัญ »

|

|

แอดมินสายเปื่อย ชอบลองอะไรใหม่ไปเรื่อยๆ รักแมว และเสียงเพลงเป็นพิเศษ |

ทิปส์ไอทีที่เกี่ยวข้อง

แสดงความคิดเห็น

ซอฟต์แวร์

ซอฟต์แวร์ แอปพลิเคชันบนมือถือ

แอปพลิเคชันบนมือถือ เช็คความเร็วเน็ต (Speedtest)

เช็คความเร็วเน็ต (Speedtest) เช็คไอพี (Check IP)

เช็คไอพี (Check IP) เช็คเลขพัสดุ

เช็คเลขพัสดุ สุ่มออนไลน์

สุ่มออนไลน์