Exascale Computing คืออะไร ? รู้จักระบบคอมพิวเตอร์ที่ประมวลผลในระดับ "Exaflop" !

Exascale Computing คืออะไร ? รู้จักระบบคอมพิวเตอร์ที่ประมวลผลในระดับ "Exaflop" !

หากย้อนกลับไปในช่วงหลายทศวรรษที่ผ่านมา มีช่วงหนึ่งในประวัติศาสตร์ที่ คอมพิวเตอร์ (PC) ต้องใช้พื้นที่เท่าทั้งห้อง หรือเป็นตึก ถึงจะทำงานได้ และนำมาใช้เพียงแค่คำนวณเลขง่าย ๆ เท่านั้นเอง แต่ทุกวันนี้เทคโนโลยีที่สามารถทำได้ระดับนั้น อยู่แค่ในมือของเราเท่านั้นเองบาง แต่ถ้าจะถามว่าทุกวันนี้ยังมีคอมพิวเตอร์บางประเภทที่ใหญ่เท่าตึกอยู่หรือไม่ ? คำตอบคือ มันยังคงมีอยู่ นั่นคือ ระบบ Exascale Computing และไม่ได้ใหญ่เปล่า ๆ นะเพราะว่ามันเร็วสุดขั้วเลย

ซึ่งระบบ Exascale Computing เป็นขอบเขตใหม่ของโลกการประมวลผล มีขุมพลังที่สามารถจัดการกับข้อมูลปริมาณมหาศาลได้ในเสี้ยววินาที พูดง่าย ๆ คือมันมีประสิทธิภาพสูงพอที่จะจำลองจักรวาล, ศึกษาความซับซ้อนของร่างกายมนุษย์ และคำนวณการเปลี่ยนแปลงของโลกในอนาคตได้เลยทีเดียว

เราลองมาสำรวจไปพร้อม ๆ กันว่า Exascale Computing คืออะไร ?, มีความเป็นมาอย่างไร ?, แตกต่างจากระบบคอมพิวเตอร์ชนิดอื่น ๆ อย่างไร ? และการนำไปใช้งานจริง ตามมาดูกันเลย

การประมวลผลระดับเอกซะสเกล คืออะไร ? (What is Exascale Computing ?)

Exascale Computing หรือ การประมวลผลระดับเอกซะสเกล เป็นอีกก้าวย่างสำคัญของเทคโนโลยีคอมพิวเตอร์ โดยคำว่า “Exascale” หมายถึงขีดความสามารถของระบบที่สามารถประมวลผลคำสั่งทางคณิตศาสตร์ได้ในระดับ หนึ่งล้านล้านล้านครั้งต่อวินาที หรือ 1018 FLOPS (Floating Point Operations Per Second) ซึ่งถือว่าเป็นหน่วยวัดมาตรฐานสำหรับวัดความเร็ว และประสิทธิภาพของซูเปอร์คอมพิวเตอร์โดยเฉพาะ ซึ่งไว้เราจะมาลงรายละเอียดกันอีกที

ภาพจาก : https://phys.org/news/2019-06-scientific-applications-exascale.html

ในทางปฏิบัติ คอมพิวเตอร์ที่มีศักยภาพระดับ Exascale ไม่ได้เพียงแค่ "เร็วมาก" เท่านั้น แต่ยังมีความสามารถในการจัดการกับ ข้อมูลขนาดใหญ่ (Big Data) และระบบที่ซับซ้อนอย่างยิ่ง ไม่ว่าจะนำไปจำลองการเปลี่ยนแปลงของภูมิอากาศโลก หรือสร้างแบบจำลองของสมองมนุษย์ในระดับเซลล์ประสาท ซึ่งที่พูดมานี้ ต้องการการคำนวณที่ทั้งแม่นยำ และต่อเนื่องมาก ๆ

แม้ว่าจะเคยมีระบบประมวลผลบางชนิดที่สามารถทำความเร็วทะลุระดับ 1 Exaflop ได้มาก่อนหน้านี้ แต่ยังไม่ถือว่าเข้าข่าย “Exascale Computing” อย่างเป็นทางการ เนื่องจากยังไม่ผ่านเกณฑ์มาตรฐานที่ใช้ในการประเมินซูเปอร์คอมพิวเตอร์ระดับโลก โดยเฉพาะการทดสอบผ่าน HPLinpack ซึ่งเป็นมาตรฐานหลักที่ใช้ในการจัดอันดับของรายชื่อ TOP500

ภาพจาก : https://www.sigma2.no/news/2022/lumi-ranked-third-top500-list-worlds-fastest-supercomputers

กล่าวได้ว่า การจะถือว่าเป็นระบบ Exascale อย่างแท้จริง ไม่ได้วัดกันแค่ตัวเลขความเร็ว แต่ยังต้องผ่านการทดสอบภายใต้เงื่อนไขที่เข้มงวด และยึดตามมาตรฐานที่ได้รับการยอมรับทั่วโลก เราลองมาดูในหัวข้อต่อไปกันว่ามีระบบใดบ้าง

ประวัติ และการพัฒนาเทคโนโลยี เอกซะสเกล (The History and Development of Exascale Technology)

ค.ศ. 2008 (พ.ศ. 2551)

แนวคิดเรื่องการพัฒนาคอมพิวเตอร์ที่สามารถประมวลผลได้ในระดับ Exascale เริ่มต้นขึ้นจากการพัฒนาระบบ Petascale ที่สามารถประมวลผลข้อมูลได้ระดับล้านล้านล้านคำสั่งต่อวินาที ซึ่งถูกใช้งานจริงครั้งแรกในปี ค.ศ. 2008 (พ.ศ. 2551) นับแต่นั้น ความฝันที่จะไปให้ถึงระดับ "Exaflop" ก็กลายเป็นเป้าหมายสำคัญของวงการซูเปอร์คอมพิวเตอร์ทั่วโลก

ค.ศ. 2018 (พ.ศ. 2561)

ในช่วงปี ค.ศ. 2009 (พ.ศ. 2552) มีการคาดการณ์ว่าโลกอาจมีคอมพิวเตอร์ระดับ Exascale ได้ภายในทศวรรษนั้น แต่การพัฒนาเป็นไปอย่างช้ากว่าที่คาด จนในปี ค.ศ. 2018 (พ.ศ. 2561) แม้จะยังไม่มีระบบใดผ่านมาตรฐาน Exascale อย่างเป็นทางการ แต่ซูเปอร์คอมพิวเตอร์ Summit จากสหรัฐอเมริกา ก็สามารถประมวลผลได้ใกล้เคียงระดับ Exaflop โดยใช้วิธีวัดเฉพาะทางในการวิเคราะห์ข้อมูลพันธุกรรม

ภาพจาก : https://tech.yahoo.com/general/articles/200-million-supercomputer-scrapped-within-173600007.html

ค.ศ. 2020 (พ.ศ. 2563)

ไม่นานหลังจากนั้น ในช่วง ค.ศ. 2020 (พ.ศ. 2563) โครงการ Folding@home ซึ่งเป็น เครือข่ายคอมพิวเตอร์แบบกระจาย (Distributed Computing) ที่ทำงานร่วมกันเพื่อศึกษาการแพร่ระบาดของไวรัสโคโรนา ก็สามารถสร้างพลังประมวลผลรวมเกินกว่า 1 Exaflop ได้เป็นครั้งแรกของโลก แต่เนื่องจากไม่ใช่ระบบแบบรวมศูนย์ (Single system) จึงไม่จัดอยู่ในนิยามของ Exascale Computing อย่างเป็นทางการ

ต่อมาในปีเดียวกัน ญี่ปุ่นได้เปิดตัวซูเปอร์คอมพิวเตอร์ Fugaku ที่สามารถทำงานได้ถึง 1.42 Exaflops โดยใช้มาตรฐานการทดสอบแบบ HPL-AI ซึ่งเหมาะสำหรับงานด้าน ปัญญาประดิษฐ์ (AI) แต่ยังไม่ผ่านเกณฑ์การวัดตามมาตรฐาน HPLinpack ที่ใช้ในรายชื่อ TOP500 เลยยังไม่จัดว่าเป็น Exascale อย่างแท้จริง

ภาพจาก : https://asia.nikkei.com/Business/Technology/Japan-s-Fugaku-keeps-position-as-world-s-fastest-supercomputer

ค.ศ. 2022 (พ.ศ. 2565)

จากนั้นก้าวสำคัญเกิดขึ้นในปี ค.ศ. 2022 (พ.ศ. 2565) เมื่อสหรัฐอเมริกาเปิดตัว Frontier ซูเปอร์คอมพิวเตอร์เครื่องแรกของโลกที่ผ่านเกณฑ์มาตรฐาน HPLinpack และสามารถทำความเร็วได้ถึง 1.102 Exaflops นับเป็น Exascale Computing อย่างเป็นทางการตัวแรกของโลก

ค.ศ. 2024 (พ.ศ. 2567)

ในปี ค.ศ. 2024 (พ.ศ. 2567) สหรัฐฯ ได้เปิดตัวระบบ Exascale เพิ่มเติมอีก 2 เครื่อง ได้แก่ Aurora และ El Capitan ซึ่งมีความสามารถสูงยิ่งขึ้น โดย El Capitan ทำความเร็วได้ถึง 1.742 Exaflops ทำให้สหรัฐอเมริกาเป็นประเทศแรก และประเทศเดียวในขณะนั้นที่มีซูเปอร์คอมพิวเตอร์ระดับ Exascale อย่างน้อย 3 ระบบ

ภาพจาก : https://en.wikipedia.org/wiki/Frontier_%28supercomputer%29

ค.ศ. 2026 (พ.ศ. 2569)

ด้านญี่ปุ่นเองคาดว่าจะมีซูเปอร์คอมพิวเตอร์ Exascale เครื่องแรกในปี ค.ศ. 2026 (พ.ศ. 2569) ซึ่งจะทำให้เป็นประเทศที่สองของโลกที่เข้าสู่ยุค Exascale อย่างเป็นทางการเช่นกัน ส่วนจีนแม้จะมีรายงานถึงระบบที่พัฒนาแล้ว เช่น Tianhe-3 และ Sunway OceanLight แต่ยังไม่มีการเปิดเผยข้อมูลว่าผ่านมาตรฐานสากล หรือขึ้นทะเบียนใน TOP500 แล้ว หรือไม่

เอกซะฟล็อป คืออะไร ? และเกี่ยวข้องอย่างไรกับ เอกซะสเกล ? (What is an Exaflop ? and How does it relate to Exascale ?)

จากที่ผ่านมาเราพูดถึง Flop แทบจะทุกย่อหน้า ดังนั้นเราลองมาดูความหมายจริง ๆ ของมันกัน ในการวัดความเร็วของคอมพิวเตอร์ นักวิทยาศาสตร์มักใช้หน่วยที่เรียกว่า FLOPS ซึ่งย่อมาจาก Floating Point Operations Per Second หรือก็คือจำนวนครั้งที่คอมพิวเตอร์สามารถทำการคำนวณทางคณิตศาสตร์กับเลขทศนิยมได้ในหนึ่งวินาที เช่น การบวก, ลบ, คูณ หรือหารแบบที่เกี่ยวข้องกับตัวเลขอย่าง 3.5 หรือ 0.75 เป็นต้น

เพื่อให้ง่ายต่อการเปรียบเทียบ และเข้าใจ นักวิทยาศาสตร์จึงเพิ่มคำนำหน้า (Prefix) ตามระดับความเร็ว เช่น

- GigaFLOPS คือพันล้านครั้งต่อวินาที (109 )

- TeraFLOPS คือล้านล้านครั้งต่อวินาที (1012)

- PetaFLOPS คือพันล้านล้านครั้งต่อวินาที (1015)

- ExaFLOPS ซึ่งหมายถึง หนึ่งล้านล้านล้านครั้งต่อวินาที (1018 )

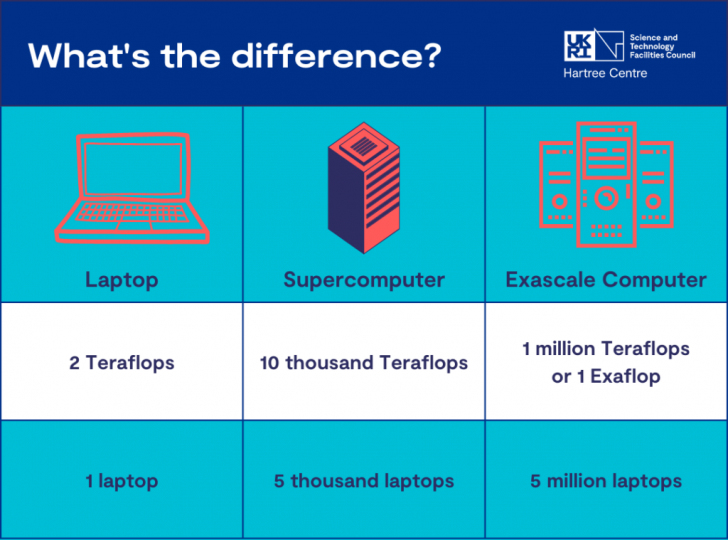

เพื่อให้เห็นภาพง่ายขึ้น คนเราสามารถทำโจทย์เลขง่าย ๆ ได้ครั้งละหนึ่งโจทย์ ในหนึ่งวินาที แต่คอมพิวเตอร์สามารถทำแบบนั้นได้ถึง 1,000,000,000,000,000,000 ครั้งในหนึ่งวินาที นั่นคือ 1 Exaflop ระบบที่สามารถประมวลผลได้ระดับ Exaflop หรือมากกว่า จะถูกจัดอยู่ในกลุ่มของ Exascale ซึ่งเป็นคำที่ใช้เรียกคอมพิวเตอร์ที่มีพลังในการประมวลผลระดับสูงสุดในปัจจุบัน ดังนั้น "Exaflop" คือหน่วยวัดความเร็ว ส่วน "Exascale" คือ คำที่ใช้เรียกระบบที่มีพลังระดับนั้นนั่นเอง

ภาพจาก : https://www.hartree.stfc.ac.uk/blog/2023/03/14/is-the-uk-ready-for-exascale-computing/

เอกซะสเกล ต่างจากระบบ ซุปเปอร์คอมพิวเตอร์แบบดั้งเดิม และ คอมพิวเตอร์แบบควอนตัม อย่างไร ? (How is Exascale different from Traditional Supercomputers and Quantum Computing ?)

แม้ว่าที่พูดมาจะเป็นคอมพิวเตอร์ทั้งหมด แต่ Exascale Computing, Supercomputer แบบเดิม, และ คอมพิวเตอร์แบบควอนตัม (Quantum Computing) ต่างก็มีพื้นฐานแนวคิด และเป้าหมายการใช้งานที่แตกต่างกันอย่างชัดเจน เราลองมาดูความแตกต่างกัน

1. Exascale vs Supercomputer แบบเดิม

Exascale Computing คือพัฒนาการขั้นถัดไปของซูเปอร์คอมพิวเตอร์แบบเดิม ซึ่งสร้างบนเทคโนโลยีพื้นฐานเดียวกันที่ใช้ในคอมพิวเตอร์ทั่วไป แต่มีความสามารถสูงกว่าอย่างมหาศาล โดยเฉพาะในเรื่องของพลังการประมวลผลที่สามารถคำนวณได้ถึง Exaflop ในขณะที่ซูเปอร์คอมพิวเตอร์แบบเดิม เช่น "Titan" มีความเร็วอยู่ที่ระดับ Petaflop หรือ 1015 เท่านั้น ซึ่งแม้จะเร็วมากแล้วในยุคนั้น แต่ก็ยังไม่สามารถรองรับความต้องการด้านการวิเคราะห์ข้อมูลระดับลึก หรือจำลองระบบที่ซับซ้อนได้เทียบเท่ากับ Exascale

2. Exascale vs Quantum Computing

ในอีกด้านหนึ่ง Quantum Computing เป็นแนวทางใหม่อย่างสิ้นเชิงของการออกแบบคอมพิวเตอร์ ที่ไม่ได้อิงกับการประมวลผลแบบ “บิต” (0 หรือ 1) เหมือนคอมพิวเตอร์ทั่วไป แต่ใช้ “คิวบิต” (Qubit) แทน ซึ่งสามารถเป็นทั้ง 0 และ 1 ได้พร้อมกันในเวลาเดียวกัน

ความแตกต่างสำคัญอยู่ที่ รูปแบบการคำนวณ คอมพิวเตอร์ทั่วไป รวมถึง Exascale ทำงานด้วยการคำนวณทีละขั้น เปลี่ยนแปลงค่าทีละตัว เมื่อมีหลายเงื่อนไข ก็ต้องคำนวณใหม่ทุกครั้ง แต่ Quantum Computer สามารถประมวลผลหลายเงื่อนไขได้พร้อมกันในคราวเดียว เพราะมันสามารถ "สำรวจทุกความเป็นไปได้" ในเวลาเดียวกัน

Exascale เหมาะกับการจำลองระบบทางฟิสิกส์, โมเลกุล, ภูมิอากาศ หรือการประมวลผลข้อมูลมหาศาลอย่างแม่นยำ และรวดเร็ว Quantum Computing จะเหมาะกับปัญหาที่มีตัวแปรจำนวนมาก และซับซ้อน เช่น เข้ารหัส (Encryption), วิเคราะห์ความน่าจะเป็น (Predictive AI), หรือแก้ปัญหาทางคณิตศาสตร์ขั้นสูง ที่คอมพิวเตอร์แบบเดิมอาจต้องใช้เวลานานเกินไป

โดยสรุปคือ Exascale เป็นซูเปอร์คอมพิวเตอร์ระดับสูงสุดในกลุ่ม “คอมพิวเตอร์แบบดั้งเดิม” ส่วน Quantum คือการออกแบบคอมพิวเตอร์ยุคใหม่ที่ใช้หลักการทางควอนตัมมาเปิดมิติใหม่ของการคำนวณ ทั้งสองไม่แทนที่กัน แต่จะเสริมกันคนละด้านนั่นเอง

การนำเอา การประมวลผลระดับเอกซะสเกล ไปใช้งาน (Applications of Exascale Computing)

เมื่อระบบคอมพิวเตอร์ก้าวเข้าสู่ยุค Exascale โอกาสใหม่ ๆ ในหลายวงการก็เริ่มเปิดออก เราลองมาสำรวจกันว่า Exascale Computing จะถูกนำไปใช้อย่างไรได้บ้าง ?

1. พลังงานสะอาด

การออกแบบระบบพลังงานที่มีประสิทธิภาพ ทนต่อสภาพแวดล้อมที่เปลี่ยนแปลง และตอบสนองต่อความต้องการได้อย่างยืดหยุ่น เป็นสิ่งที่ต้องอาศัยการคำนวณที่ซับซ้อนมาก Exascale Computing สามารถช่วยจำลองพฤติกรรมของวัสดุพลังงานในสภาพแวดล้อมสุดขั้วเพื่อเพิ่มความเข้าใจให้วิศวกรได้

ภาพจาก : https://dps.ny.gov/clean-energy-initiatives

2. งานวิจัยด้านการแพทย์

ในวงการแพทย์ โดยเฉพาะด้านมะเร็ง Exascale Computing มีบทบาทสำคัญในการวิเคราะห์พันธุกรรมของผู้ป่วย จำลองพฤติกรรมของเซลล์มะเร็ง และศึกษารูปแบบของยารักษาในระดับโมเลกุล ทั้งยังสามารถใช้ในการวิเคราะห์จีโนมสิ่งมีชีวิตขนาดใหญ่ ซึ่งมีผลต่อการพัฒนายา และแนวทางการรักษาได้อีกด้วย

ภาพจาก : https://www.vinbrain.net/public/uploads/1blog/big-data-healthcare-min.jpg

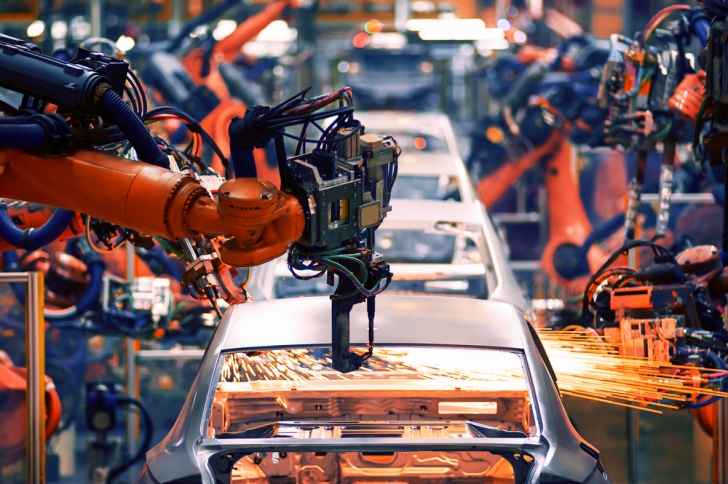

3. อุตสาหกรรมการผลิต

การพัฒนาเทคโนโลยีการผลิตรูปแบบใหม่ ๆ จำเป็นต้องมีการจำลองชิ้นส่วน หรือวิธีการอย่างละเอียดในระดับจุลภาค Exascale Computing ช่วยให้การจำลองแม่นยำขึ้น และลดระยะเวลาที่ต้องใช้ในการทดลอง ทำให้สามารถออกแบบผลิตภัณฑ์ หรือบริการ ที่ซับซ้อนได้รวดเร็ว และมีประสิทธิภาพมากขึ้น

ภาพจาก : https://seleritysas.com/2020/11/09/big-data-analytics-in-manufacturing-powering-the-industry/

4. ปัญญาประดิษฐ์ และ Machine Learning

ระบบปัญญาประดิษฐ์ (AI) และ การเรียนรู้ของเครื่องจักร (Machine Learning) จำเป็นต้องเรียนรู้จากข้อมูลจำนวนมหาศาล และ Exascale Computing ก็คือ ขุมพลังที่เหมาะสมที่สุดสำหรับการประมวลผลข้อมูลระดับ Big Data ซึ่งช่วยเร่งการฝึกโมเดลให้ฉลาดขึ้น แม่นยำขึ้น และใช้งานได้จริง

ภาพจาก : https://www.udacity.com/blog/2021/03/artificial-intelligence-vs-deep-learning-whats-the-difference.html

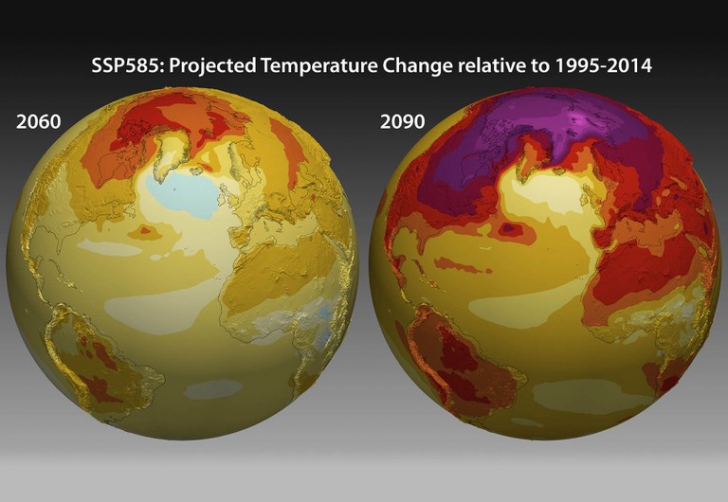

5. การประเมินความเสี่ยงจากภัยพิบัติ

ไม่ว่าจะเป็นแผ่นดินไหว, น้ำท่วม หรือการเปลี่ยนแปลงของสภาพอากาศ การจำลองเหตุการณ์เหล่านี้ต้องใช้การคำนวณซับซ้อนจำนวนมาก Exascale Computing ช่วยให้สามารถสร้างแบบจำลองที่แม่นยำ และคาดการณ์ผลกระทบได้ดีกว่าเดิม

ภาพจาก : https://www.dkrz.de/en/communication/climate-simulations

บทสรุปของ การประมวลผลระดับเอกซะสเกล (Exascale Computing Conclusions)

มาถึงบทสรุปแล้ว Exascale Computing ก็คือก้าวกระโดดครั้งสำคัญของโลกคอมพิวเตอร์ ที่สามารถประมวลผลข้อมูลได้ถึงระดับ 1018 FLOPS หรือหนึ่งล้านล้านล้านคำสั่งต่อวินาที เปิดโอกาสให้กับการวิจัยขั้นสูงในหลากหลายสาขา ด้วยความสามารถในการประมวลผลอย่างรวดเร็ว และแม่นยำเช่นนี้ จึงเปรียบเสมือน "พลังสมองของโลกอนาคต"

แต่แม้จะมีศักยภาพมหาศาล Exascale Computing ก็ยังเผชิญกับความท้าทายอยู่ โดยเฉพาะความต้องการพลังงานมหาศาล และการออกแบบฮาร์ดแวร์ที่ต้องรองรับการทำงานต่อเนื่องโดยไม่ล้มเหลว ซึ่งตามมาด้วยความซับซ้อนของซอฟต์แวร์ และฮาร์ดแวร์ ที่ต้องสามารถจัดการกับข้อมูลระดับมหภาคได้อย่างมีประสิทธิภาพ

อย่างไรก็ตาม การพัฒนา Exascale Computing ยังคงดำเนินต่อไปอย่างเข้มข้นในหลายประเทศทั่วโลก เพราะถึงแม้จะมีอุปสรรคมากมาย แต่ผลลัพธ์ที่ได้มันคุ้มค่า Exascale ไม่ใช่แค่เรื่องของ “ความเร็ว” แต่เป็นจุดเริ่มต้นของยุคใหม่ ที่เทคโนโลยีสามารถจำลอง และเข้าใจสิ่งที่ซับซ้อนได้ลึกยิ่งกว่าเดิม และเปลี่ยนแปลงวิธีการตัดสินใจของโลกไปอย่างสิ้นเชิง

ที่มา : en.wikipedia.org , www.mckinsey.com , www.hartree.stfc.ac.uk

คำสำคัญ »

คำสำคัญ »

|

|

ทิปส์ไอทีที่เกี่ยวข้อง

แสดงความคิดเห็น

ซอฟต์แวร์

ซอฟต์แวร์ แอปพลิเคชันบนมือถือ

แอปพลิเคชันบนมือถือ เช็คความเร็วเน็ต (Speedtest)

เช็คความเร็วเน็ต (Speedtest) เช็คไอพี (Check IP)

เช็คไอพี (Check IP) เช็คเลขพัสดุ

เช็คเลขพัสดุ สุ่มออนไลน์

สุ่มออนไลน์