Cluster Computing คืออะไร ? มาทำความรู้จักกับระบบคอมพิวเตอร์ชนิดนี้กัน !

Cluster Computing คืออะไร ?

เมื่อพูดถึงการประมวลผลข้อมูลในปริมาณมาก (Big Data Analytics) หลายคนอาจนึกถึง เครื่องซูเปอร์คอมพิวเตอร์ แต่รู้หรือไม่ว่า "คลัสเตอร์คอมพิวติ้ง (Cluster Computing)" ก็เป็นอีกหนึ่งทางเลือกที่น่าสนใจไม่แพ้กัน การจะนำข้อมูลเหล่านี้มาวิเคราะห์ และประมวลผลให้เกิดประโยชน์นั้น จำเป็นต้องอาศัยพลังการประมวลผลที่สูงมาก

- Port Forwarding คืออะไร ? รู้จักกระบวนการส่งต่อพอร์ต เพื่อให้ส่งข้อมูลในพอร์ตที่กำหนดไว้

- PGP Encryption คืออะไร ? มารู้จัก การเข้ารหัสความเป็นส่วนตัวอย่างดี กัน

- Windows Security กับ Microsoft Defender คืออะไร ? และ แตกต่างกันอย่างไร ?

- Optical Computing คืออะไร ? จะเป็นอย่างไรหากคอมพิวเตอร์ใช้แสงแทนกระแสไฟฟ้า

- TensorFlow คืออะไร ? รู้จักแพลตฟอร์ม เพื่อการพัฒนา Machine Learning จาก Google

ด้วยการรวมพลังของคอมพิวเตอร์หลายเครื่องเข้าด้วยกันทำให้สามารถประมวลผลข้อมูลได้เร็วขึ้น และแก้ไขปัญหาที่ซับซ้อนได้อย่างมีประสิทธิภาพ ในบทความนี้จะพาทุกคนเจาะลึกถึงเทคโนโยนี้ ความหมาย, ความเป็นมา, หลักการทำงาน, สถาปัตยกรรม, ประเภท, ประโยชน์ และการนำคลัสเตอร์คอมพิวติ้งไปใช้งาน ติดตามอ่านไปพร้อม ๆ กันเลย

คลัสเตอร์คอมพิวติ้ง คืออะไร ? (What is Cluster Computing ?)

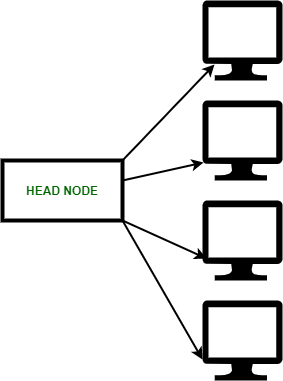

Cluster Computing หลักการง่าย ๆ คือการนำคอมพิวเตอร์หลายเครื่องมาเชื่อมต่อกันเพื่อให้ทำงานเป็นระบบเดียว คำว่า "คลัสเตอร์ (Cluster)" หมายถึง เครือข่ายของระบบคอมพิวเตอร์ที่เชื่อมโยงกัน และถูกโปรแกรมให้ทำงานแบบเดียวกัน โดยทั่วไป Cluster Computing จะ ประกอบด้วย เซิร์ฟเวอร์, เวิร์กสเตชั่น และคอมพิวเตอร์ ที่สื่อสารกันผ่าน เครือข่ายท้องถิ่น (LAN) หรือ เครือข่ายบริเวณกว้าง (WAN) เป็นต้น

ภาพจาก : https://www.geeksforgeeks.org/an-overview-of-cluster-computing/

Cluster Computing เป็นอีกรูปแบบหนึ่งของคอมพิวติ้งแบบกระจาย (Distributed Computing) ซึ่งเป็นการเชื่อมต่อคอมพิวเตอร์หลายเครื่องเข้าด้วยกันผ่านเครือข่าย เพื่อให้ทำงานร่วมกันเสมือนเป็นคอมพิวเตอร์เครื่องเดียว เพิ่มกำลังการประมวลผล และทำงานเป็นหนึ่งเดียวกัน คอมพิวเตอร์แต่ละเครื่องหรือที่เรียกว่า Nodes ในเครือข่ายคอมพิวเตอร์จะมีระบบปฏิบัติการ (OS) และหน่วยประมวลผลกลาง (CPU) ที่ควบคุมการทำงานของซอฟต์แวร์ให้ทำงานได้อย่างถูกต้อง

ความเป็นมาของ คลัสเตอร์คอมพิวติ้ง (History of Cluster Computing)

แนวคิดของ Cluster Computing เริ่มต้นขึ้นในช่วงทศวรรษที่ ค.ศ. 1960 (พ.ศ. 2503) ริเริ่มโดย Gene Amdahl จาก IBM ในปี ค.ศ. 1967 (พ.ศ. 2510) เขาได้ตีพิมพ์งานวิจัย "กฎของ Amdahl" สิ่งที่ถือว่าเป็นบทความต้นแบบเกี่ยวกับการประมวลผลแบบขนาน (Parallel Processing)

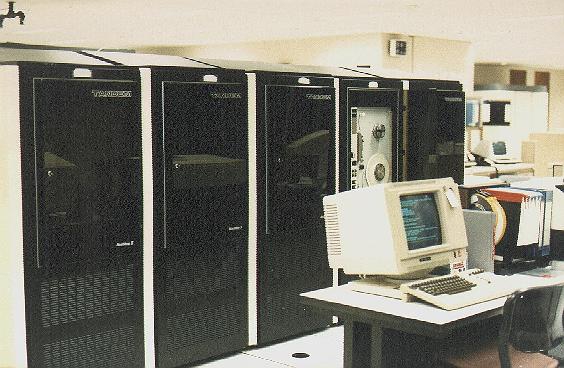

ระบบแรกที่ออกแบบมาเป็นคลัสเตอร์คือ Burroughs B5700 ในช่วงกลางทศวรรษ ค.ศ. 1960 (พ.ศ. 2503) ซึ่งสามารถให้ใช้คอมพิวเตอร์ได้สูงสุด 4 เครื่อง แต่ละเครื่องมีโปรเซสเซอร์ 1 หรือ 2 ตัว เชื่อมต่ออย่างใกล้ชิดกับ ระบบย่อยการจัดเก็บดิสก์ทั่วไป (Common Disk Storage Subsystem) เพื่อกระจายภาระงานซึ่งแตกต่างจากระบบมัลติโปรเซสเซอร์มาตรฐานในปัจจุบัน และในคอมพิวเตอร์แต่ละเครื่องสามารถรีสตาร์ทได้โดยไม่ส่งผลกระทบต่อการทำงานโดยรวม

ผลิตภัณฑ์คลัสเตอร์คอมพิวเตอร์เชิงพาณิชย์รายแรกคือระบบ "Attached Resource Computer" (ARC) ของ Datapoint Corporation ซึ่งพัฒนาขึ้นในปี ค.ศ. 1977 (พ.ศ. 2520) และใช้ ARCnet เป็นอินเทอร์เฟซ คลัสเตอร์ คลัสเตอร์คอมพิวติ้งเริ่มเป็นที่นิยมอย่างแท้จริงเมื่อ Digital Equipment Corporation เปิดตัวผลิตภัณฑ์ VAXcluster ในปี ค.ศ. 1984 (พ.ศ.2527) สำหรับระบบปฏิบัติการ VMS

ภาพจาก : https://en.wikipedia.org/wiki/Computer_cluster

ARC และ VAXcluster ไม่เพียงรองรับการประมวลผลแบบขนานเท่านั้น แต่ยังแบ่งปันระบบไฟล์ และอุปกรณ์ต่อพ่วงอีกด้วย ซึ่งแนวคิดนี้คือการใช้ข้อดีของการประมวลผลแบบขนาน ในขณะเดียวกันก็รักษาความน่าเชื่อถือ และความเป็นเอกลักษณ์ของข้อมูล คลัสเตอร์เชิงพาณิชย์ในช่วงแรกที่น่าสังเกตอีกสองรายการคือ Tandem NonStop (คลัสเตอร์คอมพิวเตอร์เชิงพาณิชย์ที่มีความพร้อมใช้งานสูงในปี ค.ศ. 1976 (พ.ศ. 2519) ) และ IBM S/390 Parallel Sysplex (ช่วงประมาณปี ค.ศ. 1994 (พ.ศ.2537) สำหรับการใช้งานทางธุรกิจเป็นหลัก

ภาพจาก : https://en.wikipedia.org/wiki/Computer_cluster#/media/File:TNSII.jpg

ในช่วงเวลาเดียวกันนี้ ขณะที่คลัสเตอร์คอมพิวเตอร์ใช้การประมวลผลแบบขนาน (Parallel processing) นอกคอมพิวเตอร์อยู่บนเครือข่ายทั่วไป กลับกันซุปเปอร์คอมพิวเตอร์เริ่มใช้การประมวลผลแบบขนานภายในคอมพิวเตอร์เดียวกัน หลังจากความสำเร็จของ CDC 6600 ในปี ค.ศ. 1964 (พ.ศ. 2507) Cray 1 ได้ถูกส่งมอบในปี ค.ศ. 1976 (พ.ศ.2519) และได้นำเสนอการประมวลผลแบบขนานภายในผ่านการประมวลผลเวกเตอร์

ในขณะที่ซุปเปอร์คอมพิวเตอร์ยุคแรก ๆ ใช้หลักการไม่รวมกันเป็นคลัสเตอร์ และอาศัยการใช้หน่วยความจำร่วมกัน แต่ในระยะเวลาต่อมาซุปเปอร์คอมพิวเตอร์บางตัวที่มีความเร็วสูง (เช่น คอมพิวเตอร์ K) ก็หันมาอาศัยสถาปัตยกรรมคลัสเตอร์เช่นกัน

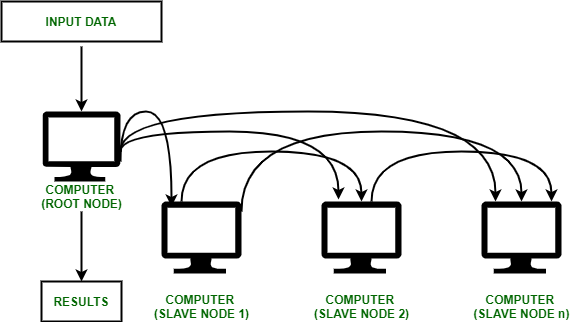

คลัสเตอร์คอมพิวติ้ง ทำงานอย่างไร ? (How does Cluster Computing work ?)

Cluster Computing ทำงานโดยการเชื่อมต่อคอมพิวเตอร์หลายเครื่องเข้าด้วยกันผ่านเครือข่ายท้องถิ่น (LAN) ในโครงสร้างของคลัสเตอร์ คอมพิวเตอร์แต่ละเครื่องในเครือข่ายเรียกว่า "Nodes" และถูกควบคุมโดยซอฟต์แวร์กลางที่ช่วยให้คอมพิวเตอร์แต่ละเครื่องสามารถสื่อสารกันได้ ผู้ใช้สามารถใช้ทรัพยากรของคอมพิวเตอร์ทั้งหมดราวกับว่าเป็นคอมพิวเตอร์เครื่องเดียว แทนที่จะเป็นคอมพิวเตอร์หลายเครื่องที่เชื่อมต่อกันผ่าน LAN

ภาพจาก : https://www.geeksforgeeks.org/an-overview-of-cluster-computing/

คลัสเตอร์คอมพิวติ้งสามารถเชื่อมต่อคอมพิวเตอร์ได้ตั้งแต่ 2 เครื่องไปจนถึงหลายพันเครื่อง ตัวอย่างเช่น คลัสเตอร์ Beowulf มักใช้คอมพิวเตอร์ทั่วไปเชื่อมต่อกันผ่าน LAN และอาจเป็นทางเลือกที่ค่อนข้างประหยัดเมื่อเทียบกับซุปเปอร์คอมพิวเตอร์สำหรับงานบางอย่าง

สถาปัตยกรรมของ คลัสเตอร์คอมพิวติ้ง (Cluster Computing Architecture)

สถาปัตยกรรมคลัสเตอร์คอมพิวติ้ง คือ การเชื่อมต่อคอมพิวเตอร์หลายเครื่องเข้าด้วยกันเพื่อทำงานเป็นระบบเดียว โดยแต่ละคอมพิวเตอร์จะเชื่อมต่อกันด้วยความเร็วสูงเช่นเครือข่ายท้องถิ่น (LAN) และเรียกว่า "Node"

โดยในแต่ละ Nodes ก็จะมีระบบปฏิบัติการ หน่วยความจำ และอุปกรณ์อินพุต/เอาต์พุต ซึ่งสามารถแบ่งประเภทของสถาปัตยกรรมคลัสเตอร์ได้ 2 แบบ คือเปิด (Open Cluster) และ ปิด (Close Cluster)

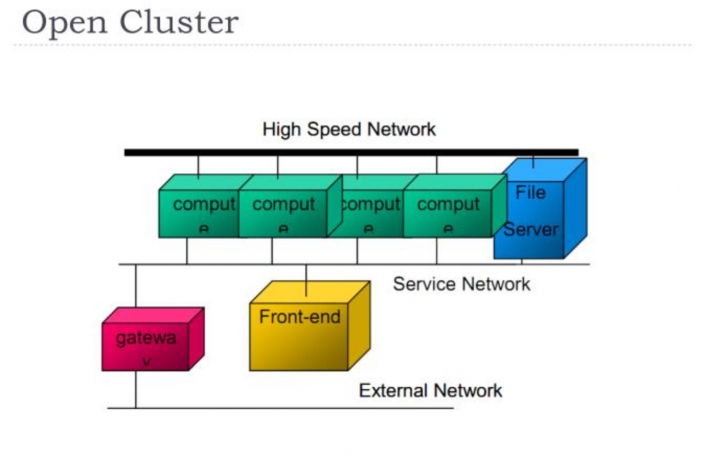

1. แบบเปิด (Open Cluster)

แบบนี้แต่ละคอมพิวเตอร์จะมี หมายเลขที่อยู่ไอพี (IP Address) ที่เป็นของตัวเอง

ภาพจาก : https://www.slideserve.com/karik/cluster-computing-powerpoint-ppt-presentation

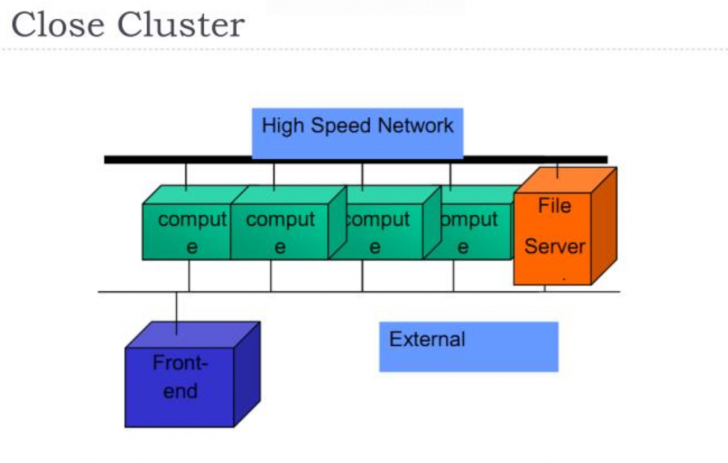

2. แบบปิด (Close Cluster)

แต่ละโหนดจะถูกซ่อนอยู่หลังโหนดเกตเวย์ เนื่องจากโหนดเกตเวย์ควบคุมการเข้าถึงโหนดอื่นๆ และ IP Address สามารถพบได้บน อินเทอร์เน็ต (Internet) คลัสเตอร์แบบปิดจึงมีความเสี่ยงด้านความปลอดภัยที่น้อยกว่าคลัสเตอร์แบบเปิด

ภาพจาก : https://www.slideserve.com/karik/cluster-computing-powerpoint-ppt-presentation

ประเภทของ คลัสเตอร์คอมพิวติ้ง (Types of Cluster Computing)

คลัสเตอร์คอมพิวติ้งมีความหลากหลายทั้งในด้านความซับซ้อน และวัตถุประสงค์ใช้งาน ตัวอย่างเช่น คลัสเตอร์แบบง่าย ๆ อาจเชื่อมต่อคอมพิวเตอร์เพียงแค่สองเครื่อง ในขณะที่ซูเปอร์คอมพิวเตอร์เช่น Aurora เชื่อมต่อมากกว่า 10,000 เครื่องเลยทีเดียว

คลัสเตอร์มีการใช้งานทางธุรกิจมากมาย เนื่องจากประสิทธิภาพสูง, สามารถปรับขนาดได้ และมีความยืดหยุ่น ถูกใช้โดยมหาวิทยาลัย และโรงเรียนแพทย์สำหรับการวิจัยทางวิทยาศาสตร์ อิงตามลักษณะของมันคลัสเตอร์คอมพิวเตอร์จะแบ่งออกเป็น 3 ประเภทได้ดังนี้

1. คลัสเตอร์ความพร้อมใช้งานสูง (High-availability clusters)

คลัสเตอร์ความพร้อมใช้งานสูง สามารถถ่ายโอนงานจากโหนดที่ล้มเหลวไปยังโหนดอื่นในเครือข่ายที่ยังทำงานอยู่โดยอัตโนมัติ ความสามารถในการปรับตัวอย่างรวดเร็ว และง่ายดาย เมื่อโหนดหนึ่งล้มเหลว ทำให้เหมาะสำหรับเวิร์กโหลดที่ไม่ต้องให้เกิดการหยุดชะงักของบริการ

ภาพจาก : https://docs.oracle.com/cd/E19906-01/820-4917/ggsxf/index.html

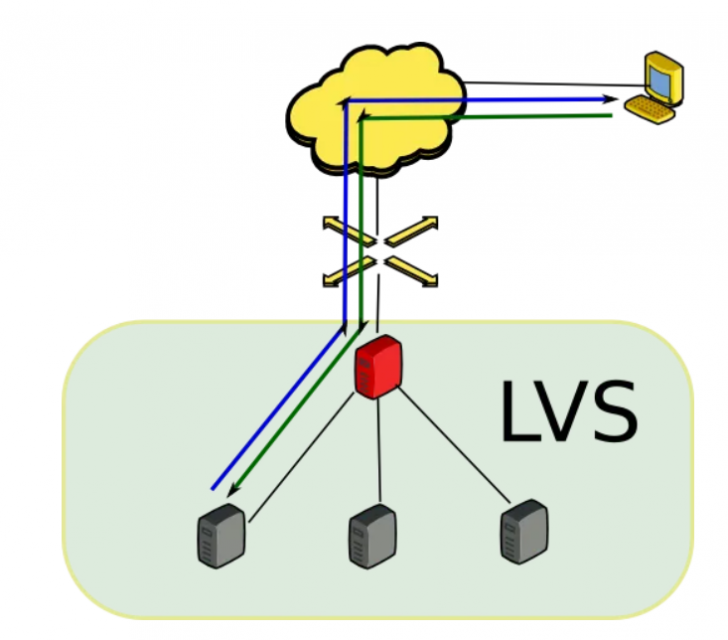

2. คลัสเตอร์ปรับสมดุลโหลด (Load-balancing clusters)

คลัสเตอร์ปรับสมดุลโหลด หรือ โหลดบาลานเซอร์ ทำหน้าที่กระจายงานอย่างเท่าเทียมกันระหว่างโหนดในคลัสเตอร์ หากไม่มีการปรับสมดุลของโหลด โหนดจะถูกท่วมด้วยงานที่ได้รับมอบหมาย และล้มเหลวบ่อยขึ้น หนึ่งในตัวอย่างที่รู้จักกันดีคือ Linux Virtual Server ซึ่งเป็นโอเพนซอร์สฟรี และถูกใช้ในการพัฒนาเซิร์ฟเวอร์ประสิทธิภาพสูงที่มีความพร้อมใช้งานสูงโดยใช้เทคโนโลยีคลัสเตอร์

ภาพจาก : https://medium.com/lvs-load-balance-clustering-configuration-on/linux-virtual-server-c0d857a1880b

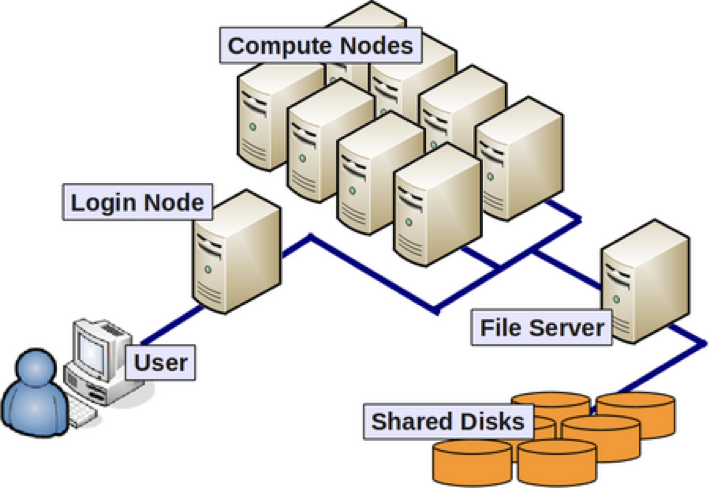

3. คลัสเตอร์คอมพิวติ้งประสิทธิภาพสูง (High-performance computing clusters)

คลัสเตอร์คอมพิวติ้งประสิทธิภาพสูง (HPC) คือ เครือข่ายของโปรเซสเซอร์ทรงพลังที่สามารถประมวลผลชุดข้อมูลขนาดใหญ่หลายมิติ หรือที่เรียกว่า Big Data ด้วยความเร็วสูงมาก ต้องการเครือข่ายที่มีประสิทธิภาพสูง และความหน่วงต่ำมากเพื่อย้ายไฟล์ระหว่างโหนด แตกต่างจากคลัสเตอร์ปรับสมดุลโหลดแ ละคลัสเตอร์ความพร้อมใช้งานสูง

ภาพจาก : https://hbctraining.github.io/Intro-to-shell-flipped/lessons/08_HPC_intro_and_terms.html

คลัสเตอร์ HPC มีกำลังการประมวลผลสูงกว่า และออกแบบมาเป็นพิเศษสำหรับการวิเคราะห์ข้อมูล เช่น การวินิจฉัยโรค, การวิเคราะห์ข้อมูลทางการเงินจำนวนมาก และการจัดลำดับจีโนม นอกจากนี้ คลัสเตอร์ HPC ยังใช้ Message Passing Interface (MPI) ซึ่งเป็นโปรโตคอลสำหรับสถาปัตยกรรมการประมวลผลแบบขนานที่ช่วยให้สามารถสื่อสารระหว่างโหนดได้อีกด้วย

4. คลัสเตอร์ปัญญาประดิษฐ์ (Artificial intelligence clusters)

คลัสเตอร์ปัญญาประดิษฐ์ คือ คลัสเตอร์คอมพิวติ้งที่สร้างขึ้นมาโดยเฉพาะสำหรับงาน ปัญญาประดิษฐ์ (Artificial Intelligence - AI) และ การเรียนรู้ของเครื่องจักร (Machine Learning - ML) เช่น การจดจำใบหน้า และเสียง การประมวลผลภาษาธรรมชาติ (NLP) และการขับขี่อัตโนมัติ คลัสเตอร์ AI ถูกออกแบบมาสำหรับอัลกอริทึมที่ใช้โมเดล AI ฝึกฝน

ประโยชน์ของ คลัสเตอร์คอมพิวติ้ง (Benefits of Cluster Computing)

คลัสเตอร์คอมพิวติ้งถูกออกแบบมาให้มีประสิทธิภาพสูง และมีความน่าเชื่อถือมากกว่าสถาปัตยกรรมคอมพิวเตอร์ประเภทอื่น ๆ ทำให้เป็นสิ่งที่ขาดไม่ได้สำหรับองค์กรสมัยใหม่ตัวอย่างเช่น คลัสเตอร์ยุคใหม่มีการทนต่อข้อผิดพลาดในตัว ซึ่งหมายถึงความสามารถในการทำงานต่อไปได้แม้ว่าโหนดใดโหนดหนึ่งในเครือข่ายจะล้มเหลว

ภาพจาก : https://hpcc.umd.edu/

นอกจากนี้ คลัสเตอร์คอมพิวเตอร์ขนาดใหญ่ยังอาศัยระบบไฟล์แบบกระจาย (DFS) และอาร์เรย์ดิสก์อิสระแบบซ้ำซ้อน (RAID) ซึ่งอนุญาตให้เก็บข้อมูลเดียวกันในตำแหน่งที่แตกต่างกันบนฮาร์ดดิสก์ไดรฟ์หลายตัว ซึ่งคลัสเตอร์คอมพิวติ้งมีประโยชน์ต่อองค์กรสมัยใหม่หลายด้าน ดังต่อไปนี้

ประสิทธิภาพ (Performance)

เนื่องจากการพึ่งพาการประมวลผลแบบขนาน คลัสเตอร์คอมพิวเตอร์จึงถือว่ามีประสิทธิภาพสูง และสามารถประมวลผลข้อมูลได้เร็วขึ้น และจัดการเวิร์กโหลดขนาดใหญ่ได้มากกว่าคอมพิวเตอร์เพียงเครื่องเดียว

ความน่าเชื่อถือ (Reliability)

คลัสเตอร์คอมพิวติ้งถือว่ามีความน่าเชื่อถือสูงเนื่องจากการรวมเทคโนโลยี DFS และ RAID ในคลัสเตอร์คอมพิวเตอร์ แม้ว่าโหนดเดียวจะล้มเหลวเครือข่ายจะยังคงทำงานต่อไป และ DFS และ RAID จะยังคงรับรองว่าข้อมูลถูกสำรองไว้ในหลายสถานที่

ความพร้อมใช้งาน (Availability)

นอกจากความน่าเชื่อถือสูงแล้ว คลัสเตอร์คอมพิวติ้งยังถือว่ามีความพร้อมใช้งานสูงเนื่องจากความสามารถในการกู้คืนอย่างรวดเร็วจากความล้มเหลวของโหนดเดียว หากคลัสเตอร์ทำงานอย่างถูกต้อง เมื่อโหนดหนึ่งล้มเหลว งานก็จะถูกถ่ายโอนไปยังอีกโหนดหนึ่งในคลัสเตอร์โดยไม่มีการหยุดชะงักของบริการ

ความสามารถในการปรับขนาด (Scalability)

คลัสเตอร์คอมพิวติ้งมีความสามารถในการปรับขนาดสูง เนื่องจากสามารถเพิ่มโหนดได้ตลอดเวลาเพื่อเพิ่มประสิทธิภาพความสามารถในการปรับทรัพยากรภายในคลัสเตอร์แบบไดนามิก หมายความว่าคลัสเตอร์สามารถปรับขนาดขึ้นหรือลงได้ตามความต้องการของผู้ใช้งานนั่นเอง

ต้นทุน (Cost)

คลัสเตอร์คอมพิวติ้งมีต้นทุนที่คุ้มค่ามากกว่าการประมวลผลแบบอื่น ๆ องค์กรสมัยใหม่หลายแห่งพึ่งพาคลัสเตอร์คอมพิวติ้งเพื่อปรับปรุงประสิทธิภาพขององค์กร ความสามารถในการปรับขนาด และความพร้อมใช้งานของโครงสร้างพื้นฐานด้านไอทีที่จับต้องได้ในราคาที่เหมาะสม

การประยุกต์ใช้ คลัสเตอร์คอมพิวติ้ง (Cluster Computing Applications)

คลัสเตอร์คอมพิวติ้งมีการใช้งานที่หลากหลาย ตั้งแต่ระดับองค์กร เช่น คลาวด์คอมพิวติ้ง และการวิเคราะห์ข้อมูล ไปจนถึงซอฟต์แวร์ที่ช่วยสร้างเอฟเฟกต์พิเศษแบบ 3 มิติ (3D) ที่น่าตื่นตาตื่นใจสำหรับ หนังภาพยนตร์ (Movie) ซึ่งต่อไปนี้คือตัวอย่างบางส่วนของการนำคลัสเตอร์คอมพิวติ้งไปใช้งาน

การวิเคราะห์ข้อมูลขนาดใหญ่ (Big Data Analytics)

คลัสเตอร์คอมพิวติ้งสามารถประมวลผลข้อมูลจำนวนมากได้อย่างรวดเร็ว และมีประสิทธิภาพ ทำให้เป็นเครื่องมือที่เหมาะอย่างยิ่งสำหรับการวิเคราะห์ข้อมูลขนาดใหญ่ ตั้งแต่เครื่องมือค้นหาอันทรงพลังของ Google ไปยังซอฟต์แวร์ที่วิเคราะห์ตลาดหุ้น จนถึงการวิเคราะห์ความรู้สึกบนโซเชียลมีเดีย คลัสเตอร์คอมพิวติ้งในการวิเคราะห์ข้อมูลนั้นมีความยอดเยี่ยม และหลากหลายมาก ๆ

ภาพจาก : https://www.linkedin.com/pulse/title-demystifying-big-data-unveiling-power-analytics-shruti-kashyap-

กราฟิก 3 มิติ (3D Graphics)

ความสามารถในการประมวลผลแบบขนานของคลัสเตอร์คอมพิวติ้ง ช่วยขับเคลื่อนกราฟิกขั้นสูงในวิดีโอเกม และภาพยนตร์ โดยการใช้คลัสเตอร์ของโหนดอิสระ แต่ละโหนดมีหน่วยประมวลผลกราฟิก (GPU) ของตัวเอง การเรนเดอร์คลัสเตอร์สามารถสร้างภาพเดียวที่ปรับเทียบได้บนหลายหน้าจอ กระบวนการนี้ช่วยลดเวลาในการสร้างภาพ 3 มิติคุณภาพสูงได้เป็นอย่างมาก

ปัญญาประดิษฐ์ และการเรียนรู้ของเครื่อง (Artificial Intelligence and Machine Learning)

ในเวิร์กโหลด AI และ ML คลัสเตอร์คอมพิวติ้งช่วยประมวลผล และวิเคราะห์ชุดข้อมูลขนาดใหญ่ได้อย่างรวดเร็ว และแม่นยำ ซึ่งเป็นส่วนสำคัญในการฝึกอบรมโมเดล AI ที่ทรงพลังซึ่งขับเคลื่อนแอปพลิเคชันยอดนิยม เช่น ChatGPT

การวิเคราะห์ความเสี่ยง (Risk Analysis)

บริษัทประกันภัย และบริษัทซื้อขายทางการเงินใช้คลัสเตอร์คอมพิวติ้งเพื่อวิเคราะห์ข้อมูล และประเมินความเสี่ยงในการซื้อหุ้นบางตัว หรือการประกันภัยให้กับลูกค้าบางราย คลัสเตอร์คอมพิวติ้งถูกนำมาใช้ในการวิเคราะห์ชุดข้อมูลขนาดใหญ่ และสกัดข้อมูลเชิงลึกที่มีความหมาย ซึ่งสามารถนำไปใช้ช่วยในการตัดสินใจทางธุรกิจได้อย่างรอบคอบ

ภาพจาก : https://compliancy-group.com/what-is-a-hipaa-security-risk-analysis/

คลัสเตอร์คอมพิวติ้ง เป็นเทคโนโลยีที่สำคัญในการขับเคลื่อนโลกดิจิทัลในปัจจุบัน ด้วยความสามารถในการรวมพลังการประมวลผลของคอมพิวเตอร์หลายเครื่องเข้าด้วยกัน ทำให้สามารถจัดการกับงานที่มีความซับซ้อนและข้อมูลขนาดใหญ่ได้อย่างมีประสิทธิภาพ ส่งผลให้เกิดประโยชน์อย่างมากในหลากหลายอุตสาหกรรม ไม่ว่าจะเป็นการวิเคราะห์ข้อมูล, การพัฒนาปัญญาประดิษฐ์, การสร้างภาพกราฟิก หรือการดำเนินธุรกิจ

ในอนาคต Cluster Computing จะมีบทบาทสำคัญยิ่งขึ้นในการขับเคลื่อนเทคโนโลยีใหม่ ๆ และนวัตกรรมต่าง ๆ โดยเฉพาะอย่างยิ่งในด้านปัญญาประดิษฐ์ และการเรียนรู้ของเครื่อง ซึ่งจะส่งผลกระทบต่อชีวิตประจำวันของผู้คนอย่างกว้างขวาง

ที่มา : www.ibm.com , en.wikipedia.org

คำสำคัญ »

คำสำคัญ »

|

|

ทิปส์ไอทีที่เกี่ยวข้อง

แสดงความคิดเห็น

ซอฟต์แวร์

ซอฟต์แวร์ แอปพลิเคชันบนมือถือ

แอปพลิเคชันบนมือถือ เช็คความเร็วเน็ต (Speedtest)

เช็คความเร็วเน็ต (Speedtest) เช็คไอพี (Check IP)

เช็คไอพี (Check IP) เช็คเลขพัสดุ

เช็คเลขพัสดุ สุ่มออนไลน์

สุ่มออนไลน์