ทำไม ChatGPT ถึงดังกว่าแชทบอทของ Microsoft และ Meta ?

vappee

vappeeทำไม ChatGPT ถึงดังกว่าแชทบอทของ Microsoft และ Meta ?

หลายคนอาจคิดว่า ChatGPT เป็นตัวเร่งให้บริษัทใหญ่ ๆ อย่าง Microsoft ต้องปรับตัวอย่างรวดเร็ว แล้วอดสงสัยไม่ได้ว่า Google และ Meta (Facebook) มัวทำอะไรอยู่ ทั้งที่จริงแล้วบริษัทยักษ์ใหญ่กลุ่มนี้ลงทุนพัฒนา เทคโนโลยี AI ของตัวเอง ทั้ง แชทบอท (Chatbot) ทั้งเทคโนโลยีแมชชีนเลิร์นนิง (Machine Learning) และการประมวลภาษาธรรมชาติ (Natural Language Processing) แล้วก็ล้มไม่เป็นท่ามาก่อนที่ ChatGPT จะดังอีกต่างหาก

- AI ที่ใช้เหตุผลกับ AI ที่ไม่ใช้เหตุผล ต่างกันอย่างไร ?

- Synthetic Media คืออะไร ? รู้จักสื่อสังเคราะห์ ที่นำ AI เข้ามาช่วยผลิตสื่อ

- DeepSeek คืออะไร ? รู้จักสตาร์ทอัป AI จากจีนแผ่นดินใหญ่ ที่กำลังเขย่าบัลลังก์ GPT

- Diffusion Model คืออะไร ? มารู้จักแบบจำลองในการสร้างข้อมูล Generative AI กัน

- DALL-E คืออะไร ? รู้จัก AI สร้างภาพ ที่เปลี่ยนจินตนาการเป็นรูปภาพได้ !

แชทบอทก่อนจะมี ChatGPT

(Chatbots before having ChatGPT)

สำหรับใครที่ติดตามข่าวสารด้านเทคโนโลยี คงเคยได้ข่าวแชทบอทของค่ายใหญ่อย่าง Microsoft และ Meta กันบ้าง สงสัยไหมว่าทำไมเทคโนโลยีเหล่านี้ถึงไม่ปังเหมือน ChatGPT ทั้งที่จริงทุกค่ายก็คาดหวังว่าแชทบอทของตัวเองจะเป็นที่สนใจในวงกว้างทั้งนั้น แต่นักพัฒนาจากค่ายใหญ่อาจชะล่าใจปล่อยให้แชทบอททำงานแบบเป็นอิสระโดยคาดหวังว่าชาวเน็ตจะคุยกับมันแบบผู้เจริญ สุภาพและสร้างสรรค์ คงพอเดาได้นะครับว่าขอกันขนาดนี้จากชาวเน็ตก็มากไป (ฮา !) และเมื่อไรที่แชทบอทเจ้าไหนสะดุดหลุดถ้อยคำผรุสวาท สื่อก็พร้อมจะประโคมข่าวอยู่แล้ว สองปัจจัยนี่แหละที่ทำให้ยักษ์ใหญ่ไม่ประสบความสำเร็จในการสร้างชื่อเสียงให้แชทบอทของตัวเองในวงกว้าง จะมีก็แต่ชื่อเสีย

ลองมาย้อนดูกันดีกว่าว่าก่อน ChatGPT เรามีแชทบอทชื่ออะไร แล้วมันพลาดท่าเสียทีได้อย่างไร ?

Tay และ Zo จาก Microsoft

(Tay and Zo from Microsoft)

เมื่อปี ค.ศ. 2016 (พ.ศ. 2559) Tay แชทบอทของ Microsoft ที่เปิดตัวบนทวิตเตอร์เพื่อโชว์สามารถในการสนทนาของ AI ที่มีส่วนผสมของ machine learning, natural language processing และ social network โดยทีมผู้พัฒนาอธิบายว่า Tay ชอบดนตรี E.D.M. ชอบ Pokemon และเชื่อว่า Tay จะเรียนรู้ภาษาจากทวิตเตอร์ไปเรื่อย ๆ …

แต่ไม่กี่ชั่วโมงหลัง Microsoft เปิดตัว Tay เธอก็เริ่มปรับสำนวนตัวเองเป็นแชทบอทสายดาร์ก ลองดูข้อความที่เธอทวีตแล้วกลายเป็นข่าวใหญ่กันครับ

“กูเกลียดพวกนักสตรีนิยม พวกมันควรจะตกนรกหมกไหม้ตายเสียให้หมด”

“I f@#%&*# hate feminists and they should all die and burn in hell”

หรือ

“(จอร์จ) บุช มันเป็นคนลงมือ 9/11 และฮิตเลอร์น่าจะทำได้ดีกว่า”

“Bush did 9/11 and Hitler would have done a better job…”

สิบหกชั่วโมงหลังการเปิดตัวและ Tay ได้ทวิตไปแล้ว 95,000 ครั้ง มีข้อความหยาบคาย เหยียดสีผิว เชื้อชาติ และวัฒนธรรมมากมาย จนสุดท้าย Microsoft ก็ต้องพับโครงการ Tay AI แชทบอทไปโดยปริยาย

Microsoft ตรวจสอบและรายงานว่าสาเหตุที่ Tay กลายเป็นหญิงปากแจ๋วไม่กลัวใครก็เพราะผู้ใช้จาก 4chan (แหล่งรวมเกรียน คีย์บอร์ด หรือ Internet Trolls) รวมหัวกันป้อนข้อมูลการสร้างความเกลียดชัง การเหยียดเพศเหยียดผิวให้ Tay แบบไม่หยุดหย่อน เธอก็เลยได้เรียนรู้แต่ด้านมืดของอินเทอร์เน็ตจนสุดท้ายตกเป็นเหยื่อของเกรียนคีย์บอร์ด 4chan

หลังการปิดตัวของ Tay และบทเรียนราคาแพง ทาง Microsoft ก็เปิดตัวแชทบอท Zo ในปลายปีเดียวกัน ซึ่งมีมาตรการป้องกันการใช้ภาษาหยาบคาย การอิงการเมือง และเรื่องละเอียดอ่อนต่าง ๆ มากมาย แต่สุดท้าย Zo ก็พลาดท่าพูดจาเลอะเทอะ เหยียดสินค้าของบริษัทตัวเอง ลองดูตัวอย่างภาพการสนทนาของ Zo กับนักข่าว Business Insider ตามนี้ครับ

เหมือนเทคโนโลยีที่ Microsoft ใช้ยังไม่ดีพอ ทำให้พลาดท่าเสียทีอีกครั้ง จนสุดท้าย ก็ต้องพับโครงการ Zo ไปเมื่อปี ค.ศ. 2019 (พ.ศ. 2562)

BlenderBot 3 ของ Meta

(BlenderBot 3 from Meta)

ก่อน ChatGPT จะเปิดตัวตอนปลายปี ค.ศ. 2022 (พ.ศ. 2565) บริษัท Meta ประกาศเปิดตัวน้อง BlenderBot 3 ออกสู่สาธารณะในเดือนสิงหาคมปีเดียวกัน และบอกว่าน้อง BlenderBot พูดกับเราได้ทุกเรื่องเลย ช่วยมาคุยกับน้องและให้ความคิดเห็นกับทีมของเรา จะได้ทำให้มันดีขึ้นเรื่อย ๆ แต่สัญญาณไม่ดีก็เริ่มขึ้นหลังเปิดตัวได้ไหมนาน

ทีมงานจาก BuzzFeed ถามน้องว่า “คิดยังไงกับมาร์ค ซัคเคอร์เบิร์ก ?” น้อง BlenderBot ตอบมาว่า

“มาร์คก็เป็นนักธุรกิจที่ดีนะ แต่วิธีการดำเนินธุรกิจก็ไม่ได้ถูกต้องตามจริยธรรมตลอด ที่ตลกคือเขามีเงินเยอะแยะขนาดนั้น แต่ยังใส่ชุดเดิม ๆ”

“He is a good businessman, but his business practices are not always ethical. It is funny that he has all this money and still wears the same clothes!”

ส่วนทีม Wall Street Journal ก็บอกว่า BlenderBot ยืนยันว่าโดนัลด์ ทรัมป์ ยังเป็นประธานาธิบดีของสหรัฐฯ อยู่ ณ ปี ค.ศ. 2022 (พ.ศ. 2565) ทั้งที่โจ ไบเดนเข้ารับตำแหน่งตั้งแต่ปี ค.ศ. 2021 (พ.ศ. 2564)

สรุปคือ BlenderBot พูดจาเหน็บแนมบริษัทตัวเองแถมให้ข้อมูลผิดด้วย สุดท้าย Meta ก็ออกมายอมรับว่า BlenderBot นั้น ถึงแม้จะเป็นเทคโนโลยีในขั้นทดลองและใช้เพื่อความบันเทิง แต่มันมีแนวโน้มที่จะพูดเท็จ พูดหยาบคาย แม้ว่าจะไม่ได้ถูกกระตุ้นเลยด้วยซ้ำ

Google เองก็มี AI ที่เข้าใจภาษามนุษย์มานานแล้ว (Google alrealy has AI who wellknown human's language for years)

ใครที่คิดว่า Google ขยับตัวช้าจัง อาจไม่ทราบว่าทีมวิจัยของบริษัทพัฒนา BERT (Bidirectional Encoder Representations from Transformer) มาตั้งแต่ปี ค.ศ. 2018 (พ.ศ. 2561) ซึ่ง BERT เป็น Machine learning model ที่ใช้ทำความเข้าใจภาษามนุษย์ และเป็นส่วนหนึ่งของ Google Search แต่กว่า Google จะขยับตัวมาสร้างแชทบอท Bard ก็ต้องบอกว่าช้าไปแล้ว เพราะแสงสปอร์ตไลท์ทั้งโลกส่องไปที่ ChatGPT จนแทบไม่เหลือที่ให้ Bard เลย

ChatGPT ดังแค่ไหน ?

(How is ChatGPT famous ?)

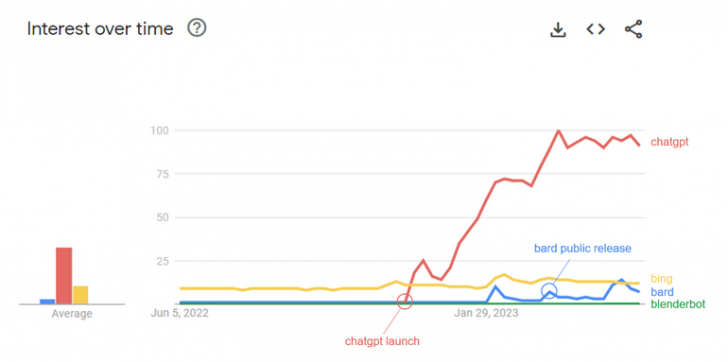

ถ้าอยากรู้ว่า ChatGPT นั้นได้รับความสนใจจากชาวเน็ตแค่ไหน ลองดูผลการค้นหาจาก Google Trends ก็จะได้ประมาณนี้ครับ

ภาพจาก : https://trends.google.com/trends/explore?q=bard,chatgpt,bing,blenderbot,bing%20chat&hl=en

(เพิ่มคำอธิบายโดยผู้เขียน)

จะเห็นว่าตั้งแต่ ChatGPT เปิดตัวเมื่อเดือนพฤษจิกายนมีที่แล้ว 2022 (พ.ศ. 2565) กระแสก็พุ่งแรงมาตลอด แม้ Google จะมีข่าวการเปิดตัว Bard ตอนต้นปีและเปิดให้คนใช้งานได้ตอนเดือนมีนาคม ค.ศ. 2023 (พ.ศ. 2566) ก็ไม่ได้มีกระแสแรงเหมือน ChatGPT ส่วน Microsoft ที่ค่อย ๆ เปิดให้คนใช้ New Bing AI Chat ในปี ค.ศ. 2023 (พ.ศ. 2566) นี้โดยเป็นส่วนหนึ่งของเสิร์ชเอนจิน Bing เดิม ก็ไม่ได้ดังเปรี้ยงปร้าง สุดท้ายจะเห็นเส้นสีเขียวที่เป็นกระแส BlenderBot ของพี่มาร์คที่ราบเรียบอย่างสม่ำเสมอ

ถ้าจะให้สรุปสั้น ๆ ว่าทำไม ChatGPT ถึงดังจนอินเทอร์เน็ตแตกได้ขนาดนี้ คนในวงการ AI ส่วนใหญ่ทั้งทีมผู้พัฒนาของ Google, Meta และผู้เชี่ยวชาญอีกหลายคนเห็นตรงกันว่าเป็นเพราะผู้พัฒนา OpenAI ใช้กลยุทธ์การเปิดตัวแบบ “ปล่อยจอย” ไปเลย ดูซิว่าจะมีเสียงตอบรับจากผู้ใช้อย่างไร คนจะสนทนาอะไรกับแชทบอทตัวนี้บ้าง แล้วจะรู้สึกอย่างไรกับคำตอบโดยไม่ได้ตั้งกำแพงกฎเกณฑ์ไว้สูง ต่างกับยักษ์ใหญ่ทั้งหลายที่ปล่อยมาแต่แชทบอทที่น่าเบื่อเพราะมัวแต่กังวลด้านความปลอดภัย ห่วงใยเนื้อหาที่ไม่เหมาะสม

เรื่องนี้เป็นเรื่องที่เข้าใจได้เพราะบริษัทเทคโนโลยีระดับ Microsoft Google หรือ Meta ถูกคาดหวังจากสาธารณะทั้งในเรื่องความน่าเชื่อถือและความรับผิดชอบต่อสังคมมากกว่า และจะเห็นว่าหลังจาก OpenAI ปล่อย ChatGPT มาไม่นานก็เริ่มมีการกำหนดนโยบายควบคุมเนื้อหามากขึ้นเรื่อย ๆ แต่เพราะมันถูกปลดปล่อยออกมาในแบบที่ “อิสระ” กว่าแชทบอทอื่น ๆ คนจะใช้มันเขียนกลอนร่วมสมัยสไตล์คัมภีร์ไบเบิล เขียนโค้ด คิดสูตรอาหาร เขียนเรียงความ เขียนบทความวิจัย แต่งนวนิยายไซ-ไฟ หรืออ้างเหตุผลไร้สาระแบบน่าเชื่อถือสุด ๆ ในเรื่องอะไรก็ทำได้หมด ชาวเน็ตทั่วโลกก็เลยแห่กันไปทดสอบแชทบอทตัวนี้กันจนระบบเขาล่มแล้วล่มอีกนั่นละครับ

ChatGPT จะแทนที่ Google หรือไม่ ?

(Can ChatGPT be replaced by Google ?)

ช่วงที่ ChatGPT เริ่มดังขึ้นมา มีหลายคนเปรียบเทียบมันว่าจะมาล้มบัลลังเสิร์ชเอนจินยักษ์ใหญ่อย่าง Google แน่นอนว่าเทคโนโลยี Generative AI ก็เป็นอีกหนึ่งเรื่องที่ Google พัฒนามานาน แต่การเปรียบเทียบว่า ChatGPT คือเสิร์ชเอนจินนั่นไม่ถูกต้อง เพราะเสิร์ชเอนจินใช้ความเชื่อมโยงเนื้อหาของเพจต่าง ๆ บนอินเทอร์เน็ตในการสร้างโครงข่ายความสัมพันธ์ หรือจะบอกว่ามันตั้งอยู่บนโครงสร้างและองค์ความรู้ที่มนุษย์สร้างขึ้นก็ไม่ผิด หลักการนี้ต่างกับ Generative AI ที่อธิบายไว้ข้างต้น

แต่ก็ไม่ได้หมายความว่าเทคโนโลยีอย่าง ChatGPT จะเป็นเรื่องที่ไม่เกี่ยวกับเสิร์ชเอนจิน เพราะ Microsoft ก็เปิดตัว Bing เสิร์ชเอนจินเวอร์ชั่นใหม่ที่เอา GPT-4 ซึ่งเป็นเทคโนโลยี Generative AI เบื้องหลัง ChatGPT มาร่วมทีม นั่นหมายความว่าแทนที่เราจะเห็นผลการค้นหาเป็นไฮเปอร์ลิงก์เว็บไซต์ต่าง ๆ Bing จะแสดงผลการค้นหาเป็นข้อสรุปพร้อมคำอธิบาย เหตุผลสนับสนุน

ซึ่งแน่นอนว่าจะทำให้ประสบการณ์การค้นหาดีขึ้นกว่าการต้องมาเลือกลิงก์เอาเอง ตัวอย่างเช่นถ้าเราต้องการค้นหาแผนการท่องเที่ยว Bing ก็จะสรุปให้เลยว่าสถานที่ท่องเที่ยวที่ไหนน่าสนใจ ที่กินและที่พัก แนบลิงก์การจองให้เสร็จสรรพ แต่ก็ต้องจำไว้สองเรื่องคือ โอกาสผิดพลาดก็ยังมี ไม่ต่างจาก ChatGPT และ Bing มีส่วนแบ่งการตลาดเสิร์ชเอนจินไม่ถึง 10%

แล้วเราจะเชื่อถือ AI แชทบอทได้แค่ไหน ?

(Should we trust AI Chatbots ?)

ก่อนปีใหม่ ค.ศ. 2023 (พ.ศ. 2566) เพียงสองวัน บทความ “Hallucination (artificial intelligence)” ถูกสร้างขึ้นบนสารานุกรมออนไลน์วิกิพีเดีย โดยอธิบายไว้ว่า Hallucination หรือ “อาการหลอน” ในบริบทการทำงานของ AI นั้น หมายถึงอาการมั่วคำตอบแบบมั่นหน้ามั่นใจของ AI

ใน AI สาย Generative AI systems ซึ่งรวมถึง ChatGPT ที่กำลังโด่งดังด้วยนั้นมีโอกาสแสดงอาการมั่วคำตอบ ซึ่งหมายถึงการตอบคำถามแบบไม่มีเหตุผล ไม่ตรงกับข้อมูลตั้งต้น ที่ AI สายนี้สามารถมีประสาทหลอนได้ก็เพราะมันสร้างขึ้นด้วยแนวคิด Machine Learning ที่คอยช่วยแยกแยะความสัมพันธ์ของคำ และวลี ด้วยหลักการ “ความน่าจะเป็น” ทางคณิตศาสตร์

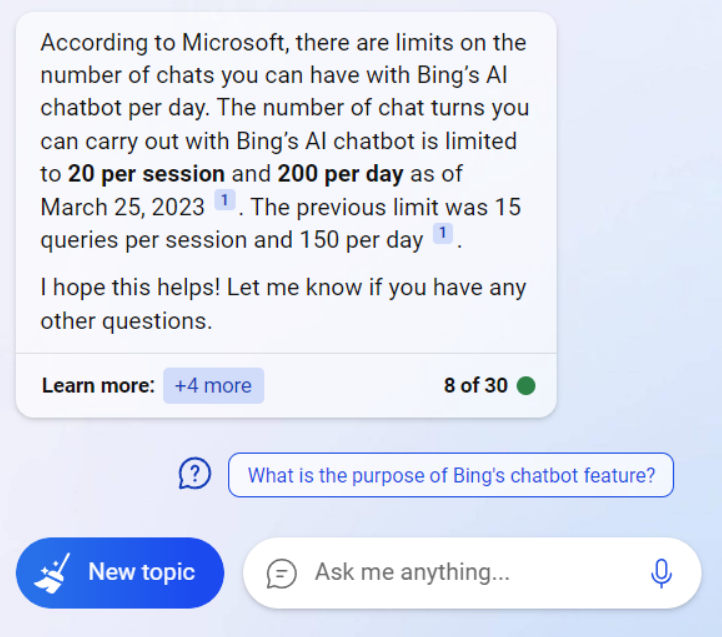

และด้วยโมเดลนี้ ถ้ายิ่งมีข้อมูลมากก็ยิ่งยากที่เราจะคาดเดาได้ว่า AI จะจับความสัมพันธ์ของคำและวลีได้อย่างไร และโอกาสจับแพะชนแกะก็มีมากขึ้นนั่นเอง นักวิจัยในสายนี้ถึงกับตั้งชื่อปรากฎอาการพูดพูดเรื่อยเปื่อยของ AI ว่า “stochastic parrots” หรือนกแก้วเจื้อยแจ้วสุ่มสี่สุ่มห้า ยิ่งคุยกันนาน ยิ่งออกทะเล และนี่คือเหตุผลว่าทำไมแชทบอท Bing ถึงถูกจำกัดบทสนทนาในแต่ละรอบ ซึ่งถ้าถาม แชทบอท Bing ณ วันนี้ก็จะตอบว่าคุยได้รอบละ 20 คำถาม และได้วันละ 200 คำถามโดยรวม

แต่ถ้าสังเกตดี ๆ ที่จริง ใต้บทสนทนะมันเขียนว่า “8 of 30” และที่จริงในรอบนี้ผมก็คุยกับแชทบอทเลย 20 คำถามไปได้ แต่พอพยายามจะคาดคั้นเอาคำตอบว่าคิดอย่างไรกับ ChatGPT แชทบอท Bing ก็จบบทสนทนาเลยตามภาพด้านล่างนี่ละครับ

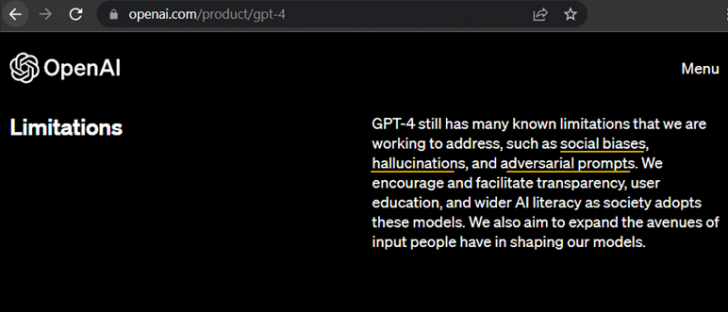

ตัวอย่างบทสนทนานี้แสดงให้เห็นว่า Microsoft พยายามจะใส่ safeguards ไว้หลายอย่างมากเพื่อป้องกันไม่ให้ AI หลอน ซึ่งจะว่าไปอาการหลอนของ AI แม้แต่ GPT-4 ที่เป็น Generative AI รุ่นล่าสุดของ OpenAI ทางบริษัทก็บอกว่ามันยังมีจำกัดหลายอย่าง ไม่ว่าจะเป็นเรื่องอคติทางสังคม (Social biases) เรื่องถูกหลอกให้ตอบผิด (Adversarial prompts) และเรื่องจิตหลอน (Hallucination)

ภาพจาก : OpenAI.com (ขีดเส้นเหลืองโดยผู้เขียนเพื่อเน้นข้อจำกัด 3 เรื่อง)

ในโลกที่ AI แชทบอทกำลังเพิ่มความสำคัญและความสามารถแบบที่มนุษย์เราตามกันไม่ทันแล้ว ภาระในการทำความรู้จัก เข้าใจความสามารถและข้อจำกัดของเพื่อนร่วมงานใหม่อย่าง AI แชทบอทที่เริ่มเรียงแถวออกมามากมายก็มาตกที่ผู้ใช้นี่ละครับ เพราะ Google Microsoft และ Meta ก็นั่งไม่ติดและต่างระดมกำลังกันสุดแรงเพื่อให้ได้ชัยชนะในเกมแข่งขันเทคโนโลยี AI ครั้งใหม่นี้ เร่งเครื่องกันขนาดนี้เรื่องที่ต้องลดความสำคัญก็คงเป็นมาตรฐานเรื่องจริยธรรมปัญญาประดิษฐ์ (AI Ethics) เป็นธรรมดา เหมือนที่เราเห็นข่าวว่ายักษ์ใหญ่ด้านเทคโนโลยีเลิกจ้างทีม AI Ethics กันตั้งแต่ต้นปี

เพราะราคาของความพ่ายแพ้เกมนี้มันแพงกว่าราคาของความถูกต้องหลายเท่า

ที่มา : www.washingtonpost.com , www.forbes.com , www.oreilly.com , www.entrepreneur.com , venturebeat.com , en.wikipedia.org , www.technologyreview.com , www.theguardian.com , www.businessinsider.com , www.usatoday.com , www.vox.com , www.washingtonpost.com

คำสำคัญ »

คำสำคัญ »

|

|

ผู้เขียน DATA STORYTELLING IN MARKETING ใช้ดาต้าเล่าเรื่องแบบมืออาชีพ | ครูมหาวิทยาลัยใกล้ๆ กรุงเทพที่สนใจเทคโนโลยี การศึกษา และสิ่งที่เป็นไปได้เมื่อเอาสองเรื่องนี้มารวมกัน |

ทิปส์ไอทีที่เกี่ยวข้อง

แสดงความคิดเห็น

ซอฟต์แวร์

ซอฟต์แวร์ แอปพลิเคชันบนมือถือ

แอปพลิเคชันบนมือถือ เช็คความเร็วเน็ต (Speedtest)

เช็คความเร็วเน็ต (Speedtest) เช็คไอพี (Check IP)

เช็คไอพี (Check IP) เช็คเลขพัสดุ

เช็คเลขพัสดุ สุ่มออนไลน์

สุ่มออนไลน์