DeepSeek คืออะไร ? รู้จักสตาร์ทอัป AI จากจีนแผ่นดินใหญ่ ที่กำลังเขย่าบัลลังก์ GPT

DeepSeek คืออะไร ? รู้จักสตาร์ทอัป AI จากจีนแผ่นดินใหญ่ ที่กำลังเขย่าบัลลังก์ GPT

ในช่วงไม่กี่ปีที่ผ่านมา วงการ ปัญญาประดิษฐ์ (AI) ได้เติบโตอย่างก้าวกระโดด กลายเป็นสมรภูมิเดือด สนามแข่งขันของบริษัทเทคโนโลยีทั่วโลก และหนึ่งในผู้เล่นที่มาแรงที่สุดในขณะนี้คือ DeepSeek สตาร์ทอัป AI จากจีนแผ่นดินใหญ่ ที่ถูกมองว่าเป็นคู่แข่งสำคัญของ ChatGPT ซึ่งเป็นโมเดลภาษาชั้นนำของ OpenAI

- รู้จัก Minitab AI เทคโนโลยีนำ AI มาคาดการณ์แนวโน้มธุรกิจ ทางแก้ปัญหา

- Adobe Acrobat Studio เปลี่ยนจากเอกสารทั่วไป สู่ข้อมูลเชิงลึกด้วย AI

- ซอฟต์แวร์ Docker คืออะไร ? รู้จักตัวช่วยผู้พัฒนาซอฟต์แวร์ ให้รันได้หลายแพลตฟอร์ม

- Domain Name System (DNS) คืออะไร ?

- Source Code คืออะไร ? รู้จัก โค้ดต้นฉบับ หัวใจหลักของซอฟต์แวร์ แอปพลิเคชัน ฯลฯ

DeepSeek ไม่เพียงแค่เป็นอีกหนึ่ง โมเดลภาษาขนาดใหญ่ (LLM) เท่านั้น แต่ยังมีข้อได้เปรียบที่อาจทำให้สามารถก้าวแซง GPT ได้ในบางด้าน ไม่ว่าจะเป็นความสามารถในการเข้าใจภาษาจีนที่เหนือกว่า อีกทั้งยังมีประสิทธิภาพในการประมวลผลที่โดยรวมแล้วคุ้มค่ากว่า และด้วยการสนับสนุนจากองค์กรเทคโนโลยีจีน สิ่งเหล่านี้อาจทำให้ DeepSeek กลายเป็นผู้เล่นสำคัญที่สามารถพลิกโฉมวงการ AI ได้

ในบทความนี้ เราจะพาทุกคนไปรู้จักกับ DeepSeek ว่ามันคืออะไร ?, มีที่มาอย่างไร ?, จุดเด่นของมันคืออะไร ? และเหตุใดมันถึงถูกจับตามองว่าอาจเป็นคู่แข่งที่ท้าทาย GPT ได้อย่างแท้จริง

DeepSeek คืออะไร ? (What is DeepSeek ?)

เรามาเริ่มด้วยการทำความรู้จักเจ้าของปัญญาประดิษฐ์ตัวนี้กันซึ่งก็คือ DeepSeek ซึ่งเป็นบริษัทปัญญาประดิษฐ์ (AI) จากประเทศจีนที่มุ่งเน้นพัฒนา โมเดลภาษาขนาดใหญ่ (Large Language Model - LLM) แบบเปิดเผยซอร์สโค้ด หรือ โอเพ่นซอร์ส (Open-Source) ที่บริษัทมีสำนักงานใหญ่ตั้งอยู่ที่เมืองหางโจว มณฑลเจ้อเจียง และได้รับการสนับสนุนด้านเงินทุนจาก High-Flyer กองทุนเฮดจ์ฟันด์ (Hedge Fund) ซึ่งเป็นกองทุนที่มีความยืดหยุ่นสูง ใช้กลยุทธ์หลากหลายเพื่อเพิ่มผลตอบแทนของจีน

ภาพจาก : https://upload.wikimedia.org/wikipedia/commons/thumb/e/ec/DeepSeek_logo.svg/1024px-DeepSeek_logo.svg.png

เป้าหมายของ DeepSeek คือการสร้าง โมเดล AI ที่สามารถแข่งขันกับบริษัทเทคโนโลยีระดับโลกได้ โดยเน้นประสิทธิภาพสูงในต้นทุนที่ต่ำกว่า จุดเด่นสำคัญของบริษัทคือการพัฒนาแบบ โอเพ่นซอร์สโมเดล AI เพื่อให้นักพัฒนา และนักวิจัยสามารถนำไปใช้ และปรับแต่งได้อย่างอิสระ ซึ่งแตกต่างจากบริษัท AI ตะวันตก ที่มักใช้โมเดลแบบปิดอย่าง OpenAI และ Google

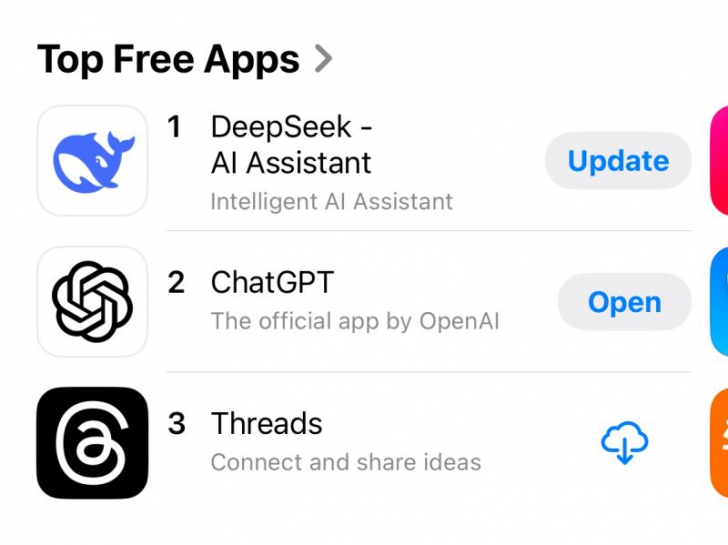

เมื่อวันที่ 10 มกราคม ค.ศ. 2025 (พ.ศ. 2568) DeepSeek ได้เปิดตัวแอปแชทบอทที่ใช้โมเดล DeepSeek-R1 บน iOS และ Android และภายใน 17 วัน แอปพลิเคชันนี้ กลายเป็นแอปพลิเคชันที่ถูกดาวน์โหลดมากที่สุดในสหรัฐฯ แซงหน้า ChatGPT ทำให้หุ้นของ Nvidia ร่วงลงชั่วคราวถึง 18% ซึ่งนี่เป็นครั้งแรกที่ AI จากจีนสามารถขึ้นแท่นแอปพลิเคชันอันดับ 1 ในตลาดสหรัฐฯ ซึ่งบ่งชี้ถึงแนวโน้มที่ผู้ใช้งานเริ่มหันมาให้ความสนใจกับ AI ทางเลือกที่มีต้นทุนต่ำกว่าแต่ให้ผลลัพธ์ที่ดีพอ ๆ กับ OpenAI

ภาพจาก : https://www.linkedin.com/posts/natolambert_DeepSeek-app-sitting-at-number-1-overall-activity-7289377740024070144-MJ8K

ความเป็นมาของ DeepSeek (History of DeepSeek)

DeepSeek ก่อตั้งขึ้นในปี ค.ศ. 2023 (พ.ศ. 2566) โดย Liang Wenfeng (เหลียง เหวินเฟิง) หนึ่งในผู้ร่วมก่อตั้ง High-Flyer (ไฮ-ฟลายเออร์) กองทุนเฮดจ์ฟันด์ ซึ่งใช้ AI วิเคราะห์ข้อมูลทางการเงิน ในช่วงแรก High-Flyer ใช้ปัญญาประดิษฐ์เพื่อเพิ่มประสิทธิภาพการลงทุน แต่เมื่อเทคโนโลยี AI ก้าวหน้าอย่างรวดเร็ว Liang จึงตัดสินใจแยกทรัพยากรออกมาก่อตั้ง DeepSeek เพื่อมุ่งเน้นไปยังการพัฒนา โมเดลภาษาขนาดใหญ่ (Large Language Model - LLM)

ภาพจาก : https://www.calcalistech.com/ctechnews/article/sjejh11uoyl

DeepSeek เริ่มต้นด้วยการเปิดตัว DeepSeek Coder ในเดือนพฤศจิกายนในปีเดียวกัน ซึ่งเป็นโมเดลโอเพ่นซอร์สที่ออกแบบมาสำหรับงานด้านการเขียนโค้ด และหลังจากนั้นได้เปิดตัว DeepSeek LLM ซึ่งเป็นโมเดลขนาด 67,000 ล้านพารามิเตอร์ (67B Parameters) ที่ถูกพัฒนาขึ้นเพื่อแข่งขันกับโมเดลภาษาขนาดใหญ่ในตลาด

ต่อมาในเดือน พฤษภาคม ค.ศ. 2024 (พ.ศ. 2567) DeepSeek-V2 ได้รับความสนใจอย่างมากเนื่องจากประสิทธิภาพที่สูง และต้นทุนที่ต่ำ ซึ่งนำไปสู่ สงครามราคาในตลาด AI ของจีน บริษัทเทคโนโลยีรายใหญ่ของจีน เช่น ByteDance, Tencent, Baidu และ Alibaba ต้องปรับลดราคาของโมเดล AI ของตนเพื่อรักษาความสามารถในการแข่งขันนั่นเอง

DeepSeek ไม่หยุดเพียงเท่านั้น ในระยะต่อมาได้เปิดตัว DeepSeek-Coder-V2 โมเดลที่มี 236,000 ล้านพารามิเตอร์ (236B parameters) ออกแบบมาเพื่อรองรับงานเขียนโค้ดที่ซับซ้อน และรองรับ Context Length สูงสุด 128K tokens พร้อมให้บริการผ่าน ส่วนต่อประสานโปรแกรมประยุกต์ (API) ในราคาที่ย่อมเยา

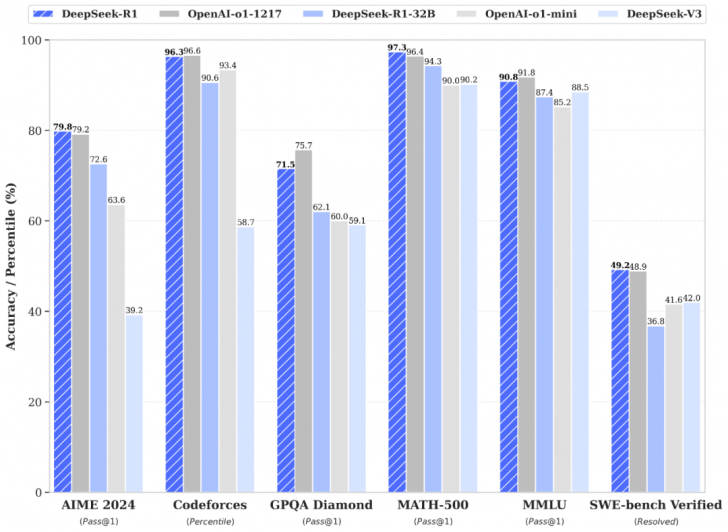

สุดท้ายในช่วงต้นปี ค.ศ. 2025 (พ.ศ. 2568) ที่ผ่านมา DeepSeek ได้เปิดตัว DeepSeek-V3 โมเดลขนาด 671,000 ล้านพารามิเตอร์ (671B parameters) ที่มีประสิทธิภาพโดดเด่น ทำคะแนนบนมาตรฐานเปรียบเทียบ (Benchmarks) สูง และใช้ทรัพยากรการประมวลผลน้อยกว่าคู่แข่งอย่างมีนัยสำคัญ นอกจากนี้ ยังมี DeepSeek-R1 ซึ่งเป็นโมเดลที่เน้นความสามารถในการให้เหตุผล (Reasoning Tasks) ถูกออกแบบมาเพื่อแข่งขันโดยตรงกับโมเดล o1 ของ OpenAI

ภาพจาก : https://api-docs.DeepSeek.com/news/news250120

นอกจากนี้ DeepSeek ยังพัฒนาโมเดลแบบกลั่น (Distilled Model) ภายใต้ชื่อ DeepSeek-R1-Distill ซึ่งต่อยอดจากโมเดลโอเพ่นซอร์สยอดนิยมอย่าง Llama และ Qwen พร้อมปรับแต่งด้วยข้อมูลสังเคราะห์จาก DeepSeek-R1 โมเดลเหล่านี้ถูกออกแบบให้มีระดับประสิทธิภาพ และความคุ้มค่าที่แตกต่างกัน รองรับการใช้งานบนฮาร์ดแวร์ที่หลากหลาย

นวัตกรรมเบื้องหลังความสำเร็จของ DeepSeek (Innovations Behind DeepSeek's Success)

DeepSeek โดดเด่นในอุตสาหกรรม AI ด้วยนวัตกรรมที่ล้ำสมัย ซึ่งช่วยเพิ่มประสิทธิภาพของโมเดล และลดต้นทุนการประมวลผลเมื่อเทียบกับโมเดลคู่แข่ง หลัก ๆ แล้ว DeepSeek มีจุดแข็งใน 4 ด้าน ได้แก่

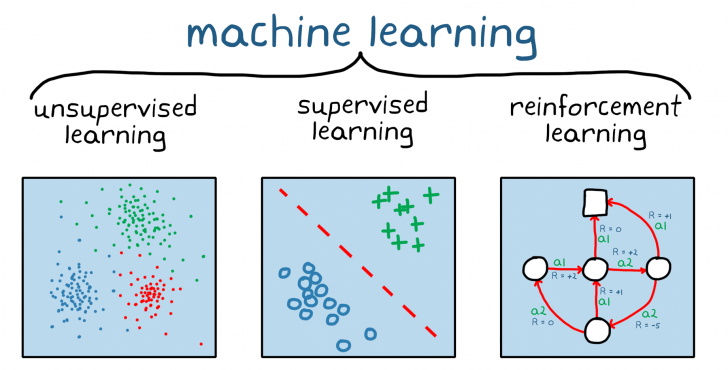

1. Reinforcement Learning – เรียนรู้ผ่านการลองผิดลองถูก

DeepSeek ใช้ Reinforcement Learning (การเรียนรู้เสริมแรง) เป็นหลัก แทนที่จะพึ่งพาการฝึกแบบมีผู้สอน (Supervised Fine-Tuning) แบบดั้งเดิม ซึ่งเทคนิคนี้ช่วยให้โมเดล เรียนรู้จากประสบการณ์โดยตรง ผ่านการลองผิดลองถูก และพัฒนาความสามารถของตัวเองโดยอัตโนมัติ จากรางวัลเชิงอัลกอริทึม (Algorithmic Rewards) ซึ่งช่วยให้ DeepSeek-R1 มีความสามารถในการให้เหตุผลที่ซับซ้อนขึ้น

ภาพจาก : https://www.mathworks.com/discovery/reinforcement-learning.html

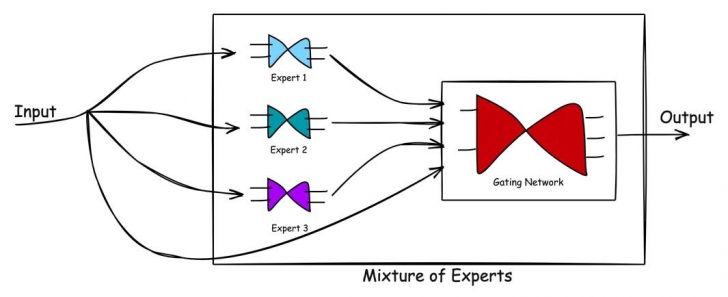

2. Mixture-of-Experts (MoE) – ลดต้นทุนการประมวลผล

DeepSeek ใช้ Mixture-of-Experts (MoE) ซึ่งเป็นสถาปัตยกรรมที่ช่วยให้โมเดล เปิดใช้งานเพียงบางส่วนของพารามิเตอร์เท่าที่จำเป็นสำหรับแต่ละงาน ทำให้ใช้พลังงาน และทรัพยากรคำนวณน้อยลง

ภาพจาก : https://pub.towardsai.net/the-mixture-of-experts-moe-an-easy-tutorial-with-python-pytorch-coding-778065191853

3. Multi-Head Latent Attention – จับประเด็นข้อมูลได้ดีขึ้น

โมเดล DeepSeek-V3 นำเทคนิค Multi-Head Latent Attention คือเทคนิคที่ช่วยให้โมเดล AI สามารถโฟกัส และประมวลผลข้อมูลหลายส่วนพร้อมกัน โดยใช้ "หัวความสนใจ (Attention Heads)" หลายตัว ทำให้เข้าใจความสัมพันธ์ของข้อมูลได้ดีขึ้น เทียบง่ายๆ กับ การอ่านหนังสือหลายเล่มพร้อมกัน แทนที่จะอ่านทีละหน้า โมเดลสามารถ "มองเห็น" หลายจุดสำคัญของข้อมูลในเวลาเดียวกัน ช่วยเพิ่มความแม่นยำ และประสิทธิภาพในการประมวลผลข้อมูลที่ซับซ้อน

4. Distillation – ถ่ายทอดความสามารถจากโมเดลใหญ่สู่โมเดลเล็ก

DeepSeek ใช้ เทคนิค Distillation เพื่อนำความสามารถของโมเดลขนาดใหญ่ ถ่ายทอดสู่โมเดลที่เล็กกว่า แต่ยังคงประสิทธิภาพสูงไว้ได้ แนวทางนี้ทำให้ AI ของ DeepSeek สามารถเข้าถึงผู้ใช้ และอุปกรณ์ที่หลากหลาย โดยไม่ต้องใช้ทรัพยากรประมวลผลมากเท่ากับโมเดลขนาดใหญ่นั่นเอง

และนอกจากเทคนิคที่ได้กล่าวมา DeepSeek ยังให้ความสำคัญกับ การเปิดเป็นโอเพ่นซอร์ส ซึ่งช่วยให้โมเดลของบริษัทกลายเป็น คู่แข่งที่น่ากลัวของ OpenAI และบริษัท AI ชั้นนำอื่น ๆ ด้วยโครงสร้างที่ล้ำสมัย และแนวคิดด้านต้นทุนที่ต่ำกว่า ทำให้ DeepSeek เป็น หนึ่งในผู้เล่นสำคัญที่อาจพลิกโฉมวงการ AI ในอนาคต

ระหว่าง DeepSeek กับ ChatGPT ใครเหนือกว่ากัน ? (Which One is better between DeepSeek and ChatGPT ?)

1. วิธีการฝึกโมเดล

หนึ่งในจุดแตกต่างที่สำคัญระหว่าง DeepSeek และ GPT คือแนวทางการฝึกโมเดล DeepSeek-R1-Zero ใช้ Reinforcement Learning (RL) เป็นหลัก ทำให้สามารถเรียนรู้จากการลองผิดลองถูก และปรับตัวได้เองโดยอัตโนมัติ โมเดลสามารถพัฒนาความสามารถด้านการให้เหตุผลได้ โดยไม่ต้องพึ่งพาการปรับแต่งแบบมีผู้กำกับ (Supervised Fine-Tuning) มากเท่ากับ GPT

ในทางกลับกัน GPT-4o ของ OpenAI ใช้ Supervised Learning ควบคู่กับ Reinforcement Learning From Human Feedback (RLHF) ซึ่งหมายความว่าโมเดลจะเรียนรู้จากชุดข้อมูลที่มีมนุษย์คัดกรอง และปรับแต่ง ทำให้มีโอกาสแม่นยำสูงขึ้นในบางบริบท

2. ประสิทธิภาพด้านต้นทุน และพลังประมวลผล

DeepSeek ใช้ Mixture-Of-Experts (MoE) และ Multi-Head Latent Attention (MLA) ซึ่งช่วยลดพลังประมวลผลที่ใช้โดยไม่ลดประสิทธิภาพ โดยรายงานจาก Epoch AI ระบุว่า DeepSeek ใช้พลังประมวลผลเพียง 1/10 ของ Meta’s Llama 3.1 แต่สามารถให้ผลลัพธ์ที่ใกล้เคียงกันได้เลย

ในขณะที่ OpenAI ยังไม่ได้เปิดเผยข้อมูลเชิงลึกเกี่ยวกับต้นทุน และพลังประมวลผลของ GPT-4o แต่เป็นที่ทราบกันดีว่า GPT-4 นั้นใช้ต้นทุนการพัฒนาอย่างน้อย 100 ล้านดอลลาร์ ในขณะที่ DeepSeek-R1 ใช้เพียง 6 ล้านดอลลาร์ ซึ่งแสดงให้เห็นถึงประสิทธิภาพด้านต้นทุนที่เหนือกว่าของ DeepSeek

3. ความสามารถในการใช้งาน และความยืดหยุ่น

DeepSeek เปิดให้ใช้งานแบบ โอเพ่นซอร์ส ซึ่งช่วยให้ผู้พัฒนาทั่วโลกสามารถเข้าถึง, ปรับแต่ง และนำไปใช้งานได้โดยไม่มีข้อจำกัด ในทางกลับกัน GPT-4o เป็นระบบปิด ซึ่งหมายความว่าผู้ใช้ต้องเข้าถึงผ่าน API ของ OpenAI เท่านั้น และไม่สามารถปรับแต่งโค้ดได้เอง

อย่างไรก็ตาม OpenAI มีข้อได้เปรียบในแง่ของ ความหลากหลายของแอปพลิเคชัน และการรองรับหลายภาษา เพราะ GPT-4o ได้รับการฝึกด้วยข้อมูลจากหลายแหล่งทั่วโลก และสามารถรองรับ มากกว่า 50 ภาษา ในขณะที่ DeepSeek มีจุดแข็งในภาษาจีนมากกว่า และอาจมีข้อจำกัดในการใช้งานภาษาอื่น ๆ

4. ข้อจำกัด และความท้าทายของแต่ละแพลตฟอร์ม

แม้ว่า DeepSeek จะมีข้อได้เปรียบด้านต้นทุน และโอเพ่นซอร์ส แต่ยังมีข้อจำกัดบางประการ DeepSeek มุ่งเน้นตลาดจีนเป็นหลัก และไม่ได้รับการสนับสนุนจากกลุ่มเทคโนโลยีชาติตะวันตก ซึ่งอาจทำให้การขยายตัวไปยังตลาดต่างประเทศเป็นไปได้ยาก ในทางกลับกัน OpenAI มีความได้เปรียบด้าน เครือข่ายพันธมิตร และการสนับสนุนจากบริษัทเทคโนโลยีใหญ่ อย่าง Microsoft ซึ่งช่วยให้สามารถขยายตลาด และใช้งานบนแพลตฟอร์มต่าง ๆ ได้ง่ายกว่า

โดยรวมแล้ว DeepSeek มีความได้เปรียบในด้านต้นทุน, ประสิทธิภาพด้านพลังงาน และการเป็นโอเพ่นซอร์ส ในขณะที่ GPT-4o ของ OpenAI มีความสามารถด้านการรองรับหลายภาษา และได้รับการสนับสนุนจากเครือข่ายพันธมิตรระดับโลก หากพิจารณาด้านความคุ้มค่า และการเข้าถึง DeepSeek อาจเป็นทางเลือกที่น่าสนใจสำหรับนักพัฒนามากกว่า แต่หากมองในแง่ของผู้ใช้งานทั่วไป ความสามารถเชิงภาษา GPT-4o ก็ยังคงเป็นตัวเลือกที่แข็งแกร่งกว่านั่นเอง

ภาพจาก : https://api-docs.DeepSeek.com/

สรุป : DeepSeek จะเปลี่ยนแปลงอนาคตของ AI อย่างไร ? (Conclusion : How Will DeepSeek Shape the Future of AI ?)

ความสำเร็จของ DeepSeek แสดงให้เห็นถึง การเปลี่ยนแปลงครั้งสำคัญในวงการ AI โดยเฉพาะอย่างยิ่งกับ DeepSeek-R1 ที่สามารถก้าวขึ้นเป็นแอปพลิเคชันฟรีอันดับ 1 บน iOS App Store ในสหรัฐฯ แซงหน้า ChatGPT ของ OpenAI ได้ ซึ่งเป็นสัญญาณชัดเจนว่าผู้ใช้งานทั่วโลกกำลังมองหา AI ทางเลือกที่มีประสิทธิภาพ และต้นทุนต่ำกว่า DeepSeek ได้พิสูจน์ว่าบริษัทจีนสามารถพัฒนา AI ที่ทัดเทียมกับเทคโนโลยีตะวันตก และได้รับความนิยมจากผู้ใช้ในตลาดสหรัฐฯ ซึ่งเป็นตลาดหลักของ OpenAI

นอกจากนี้ DeepSeek ยังเป็นโอเพ่นซอร์ส ทำให้ AI ไม่ได้ถูกจำกัดอยู่แค่ในมือของบริษัทใหญ่เพียงไม่กี่แห่ง นักพัฒนา และธุรกิจสามารถเข้าถึงเทคโนโลยีนี้ได้ง่ายขึ้น ซึ่งอาจเร่งให้เกิดนวัตกรรมใหม่ ๆ และเพิ่มการแข่งขันในตลาด AI มากขึ้นนั่นเอง ในอนาคต DeepSeek อาจเป็นแรงผลักดันให้ AI กลายเป็นเทคโนโลยีที่เปิดกว้าง และเข้าถึงได้มากขึ้น

ที่มา : www.forbes.com , www.business-standard.com , en.wikipedia.org

คำสำคัญ »

คำสำคัญ »

|

|

ทิปส์ไอทีที่เกี่ยวข้อง

ซอฟต์แวร์

ซอฟต์แวร์ แอปพลิเคชันบนมือถือ

แอปพลิเคชันบนมือถือ เช็คความเร็วเน็ต (Speedtest)

เช็คความเร็วเน็ต (Speedtest) เช็คไอพี (Check IP)

เช็คไอพี (Check IP) เช็คเลขพัสดุ

เช็คเลขพัสดุ สุ่มออนไลน์

สุ่มออนไลน์