Natural Language Processing คืออะไร ? รู้จักการประมวลผลภาษาธรรมชาติกัน

moonlightkz

moonlightkzNatural Language Processing (NLP) คืออะไร ?

เราเคยมีบทความที่เกี่ยวข้องกับความก้าวหน้าของ เทคโนโลยี AI มาแล้วหลายบทความ หลายครั้งที่เรามีการกล่าวถึงเทคโนโลยี "การประมวลผลภาษาธรรมชาติ (Natural Language Processing - NLP)" เนื่องจากมันมีบทบาทสำคัญต่อการทำงานของ AI ในปัจจุบันนี้อย่างมาก ในโอกาสที่เรามีบทความอธิบายเรื่อง "โมเดลภาษาขนาดใหญ่ (Large Language Model - LLM)" ซึ่งเป็นเทคโนโลยีที่มีความสัมพันธ์เกี่ยวดองกับ NLP อย่างมาก

- Synthetic Media คืออะไร ? รู้จักสื่อสังเคราะห์ ที่นำ AI เข้ามาช่วยผลิตสื่อ

- TDD คืออะไร ? รู้จักการพัฒนาโดยใช้การทดสอบเป็นตัวนำ เพื่อสร้างซอฟต์แวร์ที่แข็งแกร่ง

- Tensor Processing Unit คืออะไร ? รู้จักชิปประมวลผล ที่ออกแบบมาเพื่อ AI โดยเฉพาะ

- Few-Shot Learning คืออะไร ? รู้จักเทคนิค AI ที่เรียนรู้ได้จากข้อมูลเพียงไม่กี่ตัว

- Golang หรือ ภาษา Go คืออะไร ? รู้จักภาษาโปรแกรม ยุคใหม่จาก Google

เลยทำให้คิดว่า เราก็ควรมีบทความ Natural Language Processing (NLP) แยกเป็นเอกพจน์ของตัวเองด้วย เพื่อไม่ให้เป็นการเสียเวลา มาทำความรู้จักเทคโนโลยี NLP กันเลยดีกว่า

การประมวลผลภาษาธรรมชาติ คืออะไร ? (What Is Natural Language Processing ?)

Natural Language Processing (NLP) เป็นสาขา หรือแขนงหนึ่งของวิทยาการ "Artificial Intelligence (AI)" ที่ช่วยให้คอมพิวเตอร์สามารถทำความเข้าใจ, สร้าง และจัดการกับภาษาที่มนุษย์ใช้ได้ นั่นทำให้ NLP สามารถที่จะตอบสนองต่อการทำงานร่วมกับมนุษย์ในรูปแบบของข้อความที่เป็นตัวอักษร หรือเสียงพูดได้ การทำงานในรูปแบบนี้ ทางเทคนิคจะเรียกว่า "Language In (ภาษาใน)"

ในปัจจุบันนี้ ผู้บริโภคส่วนใหญ่น่าจะเคยสัมผัสประสบการณ์ในการใช้งาน NLP กันมาบ้างแล้ว เพียงแค่อาจจะไม่รู้ว่าบริการเหล่านั้นมี NLP อยู่เบื้องหลัง Virtual Assistants อย่าง Siri, Google Assistant, Cortana, Alexa ฯลฯ โดยเมื่อผู้ใช้ ถามคำถามกับ Virtual Assistants เหล่านี้ สิ่งที่ทำให้มันเข้าใจ และตอบกลับมาด้วยคำพูดที่ฟังเป็นธรรมชาติได้ ก็เพราะ NLP ที่คอยทำงานอยู่เบื้องหลังไม่ว่าจะเป็นการตอบในรูปแบบข้อความ หรือแม้แต่เสียงพูดก็ตาม

NLP ยังถูกนำไปประยุกต์ใช้ในงานอีกหลายประเภท อย่างการค้นหาข้อมูลบนเว็บไซต์, คัดกรองอีเมลขยะ หรือสแปม (Spam), แปลข้อความ หรือคำพูดจากภาษาหนึ่งไปเป็นอีกภาษา, สรุปเนื้อหา, วิเคราะห์ความรู้สึก, ตรวจสอบไวยากรณ์ หรือคำผิด ยกตัวอย่างเช่น ซอฟต์แวร์จัดการอีเมลบางตัว มีคุณสมบัติในการแนะนำคำตอบที่เหมาะสมกับการตอบอีเมลให้อัตโนมัติ โดยพิจารณาจากเนื้อหาที่ได้รับ ที่มันทำได้ก็เพราะใช้ NLP ในการอ่าน, วิเคราะห์ และสร้างเนื้อหาได้

ยังมีศัพท์เชิงเทคนิคอีกหลายคำที่มีความหมายเหมือนกับ NLP ที่น่าจะได้ยินกันบ่อยครั้งก็คือ "Natural Language Understanding (NLU)" และ "Natural Language Generation (NLG)" ซึ่งก็หมายถึงการทำให้คอมพิวเตอร์สามารถทำความเข้าใจ และสร้างภาษามนุษย์ได้ อย่างไรก็ตาม ถ้าจะเจาะลึกลงไปในรายละเอียด NLG เป็นคุณสมบัติที่ใช้อธิบายสิ่งที่เกิดขึ้น หรือที่เรียกว่า "Language Out" (ภาษานอก) โดยมันจะสรุปข้อมูลที่มีความหมายให้อยู่ในรูปแบบข้อความ ด้วยหลักการที่เรียกว่า "Grammar of Graphics" (ไวยากรณ์ของกราฟิก)

ภาพจาก https://content.techgig.com/technology/decoding-nlp-how-computers-understand-human-language/articleshow/92039785.cms

ในทางปฏิบัติแล้ว NLU มักใช้แทนความหมายของ NLP ซึ่งหมายถึงการที่คอมพิวเตอร์เข้าใจโครงสร้าง และความหมายของภาษาทั้งหมดที่มนุษย์ใช้ในการสื่อสาร เพื่อทำให้นักพัฒนา และผู้ใช้ สามารถโต้ตอบกับคอมพิวเตอร์ด้วยภาษาธรรมชาติได้ ในขณะที่ NLP เป็นสาขาวิชาทางวิศวกรรม ที่เกี่ยวข้องกับการพัฒนาให้คอมพิวเตอร์สามารถเข้าใจ, สร้าง หรือจัดการกับภาษามนุษย์ได้

การประมวลผลภาษาธรรมชาติ ทำงานอย่างไร ? (How does Natural Language Processing work ?)

โดยพื้นฐานแล้ว Natural Language Processing (NLP) เกิดจากการทำงานร่วมกันระหว่าง Computational Linguistics (ภาษาศาสตร์เชิงคำนวณ), และในส่วนของ อัลกอริทึม การเรียนรู้ของเครื่อง (Machine Learning) กับ การเรียนรู้เชิงลึก (Deep Learning) เป็นต้น

Computational Linguistics หรือภาษาศาสตร์เชิงคำนวณ เป็นพหุวิทยาการที่นำภาษาศาสตร์ และวิทยาการคอมพิวเตอร์มาผสมผสานกันเพื่อพัฒนาแบบจำลองเชิงตรรกะของภาษาธรรมชาติจากมุมมองในเชิงคำนวณ โดยครอบคลุมภาษาที่มนุษย์ใช้ทั้งรูปแบบการพูด และเขียน ตัวอย่างหัวข้อที่มีการศึกษาก็อย่างเช่น การจดจำเสียง (Speech Recognition) และ การสังเคราะห์เสียง (Speech Synthesis) ซึ่งเป็นหัวใจสำคัญต่อการทำให้คอมพิวเตอร์สามารถเข้าใจ หรือสร้างภาษาพูดได้

โดยหลัก Computational Linguistics ที่ NLP ใช้ในการวิเคราะห์จะแบ่งออกเป็น 2 ประเภท คือ Syntactical Analysis (การวิเคราะห์ไวยากรณ์) และ Semantical Analysis (การวิเคราะห์เชิงความหมาย)

- Syntactical Analysis (การวิเคราะห์ไวยากรณ์) : เป็นกระบวนการที่ใช้ในการกำหนดความหมายของคำ, วลี หรือประโยค ด้วยการวิเคราะห์โครงสร้างไวยากรณ์ของคำเหล่านั้น ตามกฎการใช้ไวยากรณ์ที่ถูกเตรียมไว้ล่วงหน้า

- Semantical Analysis (การวิเคราะห์เชิงความหมาย) : วิธีการนี้ใช้ผลลัพธ์ที่ได้มาจากการทำ Syntactical Analysis (การวิเคราะห์ไวยากรณ์) มาหานิยาม และตีความหมายของคำเหล่านั้น ตามรูปแบบโครงสร้างของประโยค

ในส่วนของการวิเคราะห์โครงสร้างของคำ ก็มีการแบ่งออกเป็น 2 รูปแบบด้วยเช่นกัน ประกอบไปด้วย Dependency Parsing (การวิเคราะห์ความสัมพันธ์ระหว่างคำ) และ Constituency Parsing (การวิเคราะห์โครงสร้างประโยค)

- Dependency Parsing (การวิเคราะห์ความสัมพันธ์ระหว่างคำ) : จะมองไปที่ความสัมพันธ์ที่เกิดขึ้นระหว่างคำแต่ละคำ เช่น เพื่อค้นหาว่าคำไหนเป็นประธาน, กริยา, นาม, กรรม ฯลฯ

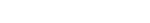

- Constituency Parsing (การวิเคราะห์โครงสร้างประโยค) : เป็นการสร้าง Treebank หรือ Syntax Tree เพื่อแสดงโครงสร้างทางไวยากรณ์ของประโยค หรือกลุ่มคำในรูปแบบของต้นไม้ที่มีกิ่งก้านอย่างเป็นระเบียบ ซึ่งโครงสร้างนี้จะเป็นพื้นฐานการทำงานของการแปลภาษา และการจำเสียงพูด ทำให้ผลลัพธ์นี้เข้าใจได้ทั้งโดยโมเดล NLP และมนุษย์

Syntax Tree

ภาพจาก https://www.geeksforgeeks.org/syntax-tree-natural-language-processing/

Self-supervised learning (SSL) หรือการเรียนรู้แบบกึ่งควบคุมตัวเอง เป็นหนึ่งในเทคนิคที่ถูกใช้ในการฝึกฝนโมเดลของ Machine Learning ที่นำข้อมูลที่ยังไม่ถูกติดป้ายกำกับ (Unlabeled Data) ในการฝึกฝน SSL ช่วยให้โมเดลสามารถเรียนรู้จากข้อมูลที่มีอยู่มากมาย โดยไม่ต้องพึ่งพาข้อมูลที่ติดป้ายกำกับทั้งหมด ทำให้การฝึกโมเดลมีประสิทธิภาพมากขึ้นทั้งในด้านเวลา และค่าใช้จ่าย เนื่องจากมันช่วยลดความจำเป็นในการใช้ข้อมูลที่ต้องติดป้ายกำกับด้วยมนุษย์

ประเภทของ การประมวลผลภาษาธรรมชาติ (Types of Natural Language Processing)

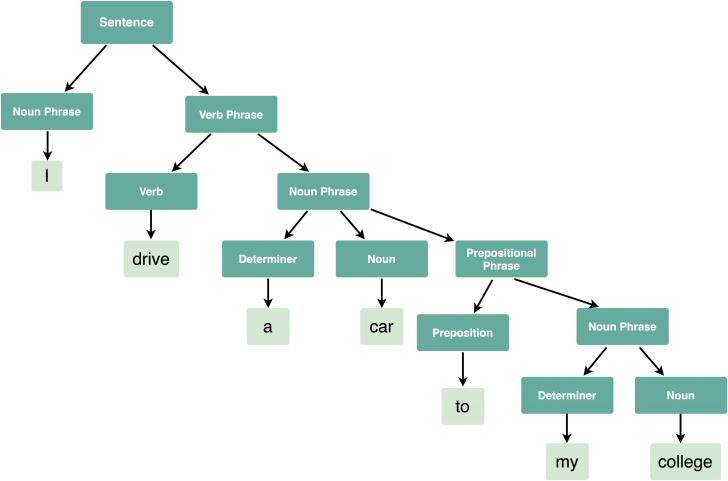

การทำงานของของ Natural Language Processing (NLP) ถูกแบ่งออกเป็น 3 ประเภทใหญ่ ดังนี้

แบบใช้กฎ (Rules-based NLP)

เทคโนโลยี NLP ในยุคเริ่มต้นไม่ได้มีความซับซ้อนเฉกเช่นปัจจุบันนี้ อัลกอริทึมในการตัดสินใจมีความเรียบง่าย อาศัยเพียงกฎ "If-Then" โดยเริ่มจากการตรวจสอบเงื่อนไข ถ้ามันตรงกับเงื่อนไขที่กำหนด ก็จะดำเนินการต่อตามข้อกำหนดที่เงื่อนไขระบุไว้ ดังนั้นการทำงานของ Rules-based NLP จึงมีข้อจำกัดสูง สามารถให้คำตอบได้เฉพาะคำถามที่ถูกเตรียมไว้แล้วเท่านั้น

แบบสถิติ (Statistical NLP)

เป็น NLP ที่มีความซับซ้อนมากขึ้น มีการนำหลักสถิติเข้ามาจัดประเภทกลุ่มคำ, ความหมาย และติดป้ายกำกับองค์ประกอบของข้อความ และข้อมูลเสียง เพื่อกำหนดความน่าจะเป็นทางสถิติให้กับความหมายที่เป็นไปได้ โดยอาศัยเทคโนโลยี Machine Learning ทำให้สามารถวิเคราะห์ภาษาศาสตร์ได้อย่างละเอียดแม่นยำ

Statistical NLP ยังกลายเป็นรากฐานให้กับเทคนิคที่จำเป็นต่อการทำแผนที่องค์ประกอบภาษาอีกหลายอย่าง เช่น การแสดงผลคำ และกฎการใช้ไวยากรณ์ในรูปแบบเวกเตอร์ (Vector), แบบจำลองมาร์คอฟ (Markov Models) ซึ่งเป็นแบบจำลองทางคณิตศาสตร์ที่มีสมมติฐานว่า การเปลี่ยนแปลงของสถานะในอนาคตจะขึ้นอยู่กับสถานะปัจจุบันเท่านั้น

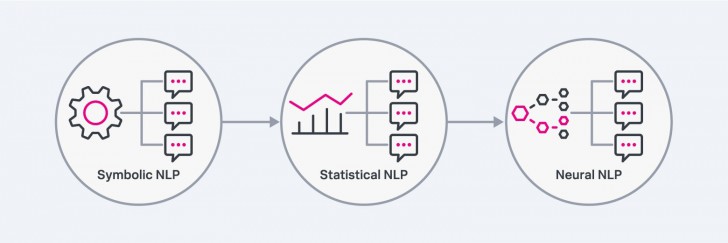

แบบเรียนรู้เชิงลึก (Deep Learning NLP)

การเรียนรู้เชิงลึก (Deep Learning) เป็นเทคโนโลยีหลักของการพัฒนา NLP ในยุคปัจจุบันนี้ ด้วยการนำข้อมูลข้อความ และเสียงจำนวนมหาศาล มาสร้างโมเดลภาษาผ่านเครือข่ายประสาทเทียม (Neural Network) อาจมองว่านี่เป็นการต่อยอดมาจาก Statistical NLP ให้ดียิ่งขึ้นว่าเดิม

ภาพจาก : https://www.splunk.com/en_us/blog/learn/language-models-slm-vs-llm.html

ซึ่ง Deep Learning NLP ก็มีโมเดลย่อยอยู่หลายประเภท ตัวอย่างเช่น

โมเดล Sequence-to-Sequence (seq2seq)

เป็นโมเดลที่มีพื้นฐานมาจากโครงข่ายประสาทเทียมแบบวนซ้ำ Recurrent neural networks (RNN) โดยโมเดล "seq2seq" นิยมใช้ในการทำแปลภาษา เช่น แปลงข้อความจากภาษาฝรั่งเศส ให้เป็นภาษาอังกฤษ

โมเดล Transformer

ด้วยการทำ "Tokenization" กระบวนการแบ่งข้อความให้ออกเป็นหน่วยที่เล็กที่สุด ที่ยังมีความหมาย สร้างเป็น Token (โทเค็น) อาจเป็นคำ, ตัวเลข หรือเครื่องหมายวรรคตอน ร่วมกับเทคนิค "Self-Attention" ซึ่งเป็นกลไกที่ช่วยให้โมเดลสามารถเลือกคำที่ในประโยคได้เอง ด้วยการเปรียบเทียบคำทุกคำที่มีอยู่ภายในประโยคด้วยกันเอง

ทำให้โมเดล Transformer มีประสิทธิภาพต่อการฝึกฝนโมเดลกับฐานข้อมูลขนาดใหญ่ด้วยเทคนิค Self-supervised learning (SSL) หรือการเรียนรู้แบบกึ่งควบคุมตัวเองเป็นอย่างมาก

โมเดล Autoregressive

เป็นโมเดล Transformer ชนิดหนึ่งที่ทำงานอย่างเฉพาะเจาะจง ให้สามารถคาดการณ์คำถัดไปอย่างเป็นลำดับ ซึ่งเป็นก้าวกระโดดที่สำคัญต่อเทคโนโลยีสร้างข้อความเป็นอย่างมาก แพลตฟอร์ม AI หลายตัวที่แพร่หลายในปัจจุบันนี้ อย่าง GPT, Llama, Claude และ Mistral

โมเดล Foundation

หมายถึงโมเดลที่มีบริษัทสร้าง และจัดเตรียมไว้ล่วงหน้า เพื่อให้ลูกค้าที่สนใจซื้อไปใช้ในโครงการที่ต้องการใช้งาน NLP เร่งความเร็วในการพัฒนาไม่ต้องเริ่มต้นใหม่จากศูนย์ ตัวอย่างเช่น โมเดล Granite ของ IBM, Stable Diffusion จาก Stability AI, Titan จาก Amazon ฯลฯ

ความเป็นมาของ การประมวลผลภาษาธรรมชาติ (History of Natural Language Processing)

จุดเริ่มต้นของแนวคิด Natural Language Processing (NLP) เริ่มต้นขึ้นในปี ค.ศ. 1940 (พ.ศ. 2483) แอลัน ทัวริง (Alan Turing) ได้เผยแพร่บทความ "Computing Machinery and Intelligence" (เครื่องจักรคอมพิวเตอร์ และปัญญาประดิษฐ์) ซึ่งมีการนำเสนอสิ่งที่ในปัจจุบันนี้เรียกว่า "Turing Test" บททดสอบว่าคอมพิวเตอร์มีความจริงหรือไม่ ? ซึ่งมันมีแนวคิดที่เกี่ยวข้องกับความสามารถในการตีความ และการสร้างภาษาธรรมชาติ จากนั้น NLP ก็ถูกพัฒนาเรื่อยมากจวบจนปัจจุบัน โดยสามารถแบ่งช่วงเวลาได้ออกเป็น 4 ยุค

ค.ศ. 1950 - 1990 (พ.ศ. 2493 - 2533)

ในยุคเริ่มต้น การพัฒนา NLP ส่วนใหญ่จะเป็นแบบใช้กฎ (Rules-based NLP) ที่นักภาษาศาสตร์เป็นผู้สร้างกฎเกณฑ์ที่คอมพิวเตอร์จะใช้ในการประมวลผลภาษา ในปี ค.ศ. 1954 (พ.ศ. 2497) มหาวิทยาลัยจอร์จทาวน์ (Georgetown University) ได้ร่วมมือกับบริษัท IBM พัฒนาเครื่องแปลภาษา ที่สามารถแปลประโยคภาษารัสเซีย ให้เป็นภาษาอังกฤษแบบอัตโนมัติได้มากกว่า 60 ประโยค

ถัดมาในช่วงระหว่าง ค.ศ. 1980 - 1990 (พ.ศ. 2523 - 2533) ทิศทางการพัฒนาเริ่มมีความซับซ้อนมากขึ้น มีความพยายามพัฒนาการวิเคราะห์ไวยากรณ์, วิเคราะห์รูปคำ, ความหมาย ฯลฯ

ค.ศ. 1990 - 2000 (พ.ศ. 2533 - 2543)

แนวทางการพัฒนา NLP แบบใช้กฎ (Rules-based NLP) เริ่มถูกแทนที่ด้วยวิธีการแบบสถิติ (Statistical NLP) ซึ่งเป็นผลที่สืบเนื่องมาจากวิทยาการคอมพิวเตอร์ที่มีประสิทธิภาพสูงขึ้น ฮาร์ดแวร์มีความเร็วสูงพอที่จะนำมาใช้ในการกฎสถิติทางภาษาศาสตร์ได้โดยที่ไม่จำเป็นต้องพึ่งพานักภาษาศาสตร์ในการสร้างกฎทั้งหมดเพียงอย่างเดียวอีกต่อไป

ส่งผลให้การพัฒนาระบบประมวลผลภาษาธรรมชาติ Natural Language Processing (NLP) ที่ขับเคลื่อนด้วยข้อมูลกลายเป็นกระแสหลักในทศวรรษนี้ เปลี่ยนจากการพึ่งพานักภาษาศาสตร์มาเน้นเทคนิคทางวิศวกรรมมากขึ้น โดยอาศัยวิทยาศาสตร์หลากหลายสาขา แทนที่จะเจาะลึกเฉพาะทางภาษาศาสตร์เพียงอย่างเดียว

ค.ศ. 2000 - 2020 (พ.ศ. 2543 - 2563)

กล่าวได้ว่าเป็นยุคทองของการพัฒนา NLP เลยก็ว่าได้ มีการนำเทคนิคใหม่ ๆ ถูกพัฒนาขึ้นมาหลายอย่าง ซึ่งเราได้กล่าวถึงไปแล้วในหัวข้อ "Natural Language Processing (NLP) ทำงานอย่างไร ?" โดยส่วนหนึ่งก็มาจากความก้าวหน้าด้านพลังในการคำนวณของคอมพิวเตอร์ในยุคนี้ ด้วยพลังของ Machine Learning, Deep Learning ฯลฯ ทำให้ NLP ในยุคนี้สามารถรวมวิธีการประมวลผล NLP ระหว่างภาษาศาสตร์แบบดั้งเดิม และวิธีการทางสถิติเข้าด้วยกันได้อย่างชาญฉลาด สร้างผลลัพธ์ที่แม่นยำจนผู้ใช้แทบไม่รู้สึกเลยว่า กำลังสนทนากับคอมพิวเตอร์อยู่

น่ำทำให้การประยุกต์ใช้งาน NLP เข้ามาสู่ชีวิตประจำวันของผู้ใช้งานทั่วไปมากขึ้น เช่น Chatbot, Virtual Assistant, แอปพลิเคชันแปลภาษา, Generative AI ฯลฯ

ภาพจาก : https://www.youtube.com/watch?v=V8qrVleGY5U

การประมวลผลภาษาธรรมชาติ กับ โมเดลภาษาขนาดใหญ่ แตกต่างกันอย่างไร ? (What is the difference between NLP and LLM ?)

ความก้าวหน้าของเทคโนโลยี AI ในปัจจุบันนี้ สามารถช่วยแก้ปัญหาต่าง ๆ ได้ในหลากหลายอุตสาหกรรม ซึ่งหัวใจที่ทำให้มันเข้ามามีบทบาทสำคัญคือ ช่องว่างในการสื่อสารระหว่างภาษามนุษย์ กับคอมพิวเตอร์ที่แคบลง ด้วยความฉลาดของ AI มันเข้าใจคำสั่งของมนุษย์ได้ดี และเป็นธรรมชาติมากขึ้น ซึ่งเบื้องหลังการทำงานนั้นก็มี การประมวลผลภาษาธรรมชาติ (Natural Language Processing - NLP) และ โมเดลภาษาขนาดใหญ่ (Large Language Models - LLM) อยู่เบื้องหลัง

ถ้าเพื่อน ๆ ได้อ่านบทความเรื่อง Large Language Models (LLM) ที่เราเคยเผยแพร่ไปก่อนหน้านี้แล้ว อาจเกิดความรู้สึกสงสัยว่า แล้ว LLM มันแตกต่างจาก NLP อย่างไร ?

ข้อมูลเพิ่มเติม : Large Language Model คืออะไร ? มารู้จักโมเดลภาษาขนาดใหญ่ กัน

โดยพื้นฐานแล้ว ทั้ง NLP และ LLM เป็นเทคโนโลยีที่ช่วยให้เราสามารถสื่อสารกับคอมพิวเตอร์ด้วยภาษามนุษย์ได้ แต่ว่าหน้าที่ในการทำงานของมันมีความแตกต่างกัน

NLP เป็นเหมือนนักแปลภาษา ที่รวมหน้าที่วิเคราะห์ และจัดการภาษามนุษย์ตามกฎ และโครงสร้างที่กำหนดไว้แล้ว ช่วยให้เครื่องจักรสามารถเข้าใจไวยากรณ์ และบริบทต่าง ๆ ของภาษาได้ ซึ่งมีความสำคัญต่อการทำความเข้าใจอารมณ์, ความหมายที่แท้จริง และทำการแปลภาษาได้

ในขณะที่ LLM ทำหน้าที่เหมือนสมองที่เต็มไปด้วยข้อมูลข้อความจำนวนมหาศาล มันมีความสามารถในการเรียนเรียนรู้ที่จะทำนาย และใช้ภาษาได้เหมือนมนุษย์ ทำให้เครื่องจักรสามารถสนทนา, เขียนเนื้อหาประเภทต่าง ๆ และตอบคำถามในรูปแบบที่เหมือนกับว่ากำลังสื่อสารกับมนุษย์อยู่ ไม่ใช่คำตอบที่ถูกเตรียมไว้ตายตัว

จะเห็นได้ว่า แม้ NLP และ LLM จะเกี่ยวข้องกับการเข้าใจภาษาเหมือนกัน แต่มันเป็นคนละเทคโนโลยี มีกระบวนการทำงานที่แตกต่างกัน

ข้อดี-ข้อเสีย ของ การประมวลผลภาษาธรรมชาติ (Natural Language Processing Pros and Cons)

ข้อดีของ Natural Language Processing (NLP)

การวิเคราะห์ข้อมูลขนาดใหญ่

เทคโนโลยี NLP สามารถวิเคราะห์ข้อความในเอกสารทุกชนิด ไม่ว่าจะเป็นอีเมล, โซเชียลมีเดีย, บทความออนไลน์, เอกสารภายใน ฯลฯ ประมวลผลข้อมูลจำนวนมากสรุปเนื้อหาออกมาให้ผู้ใช้ได้ในเวลาเพียงไม่กี่วินาทีไปจนถึงไม่กี่นาที ในขณะที่หากมนุษย์ต้องสรุปด้วยตนเอง อาจจะต้องใช้เวลาถึงสองสัปดาห์กว่าจะเสร็จ

แม่นยำสูง และช่วยลดต้นทุน

มนุษย์ไม่ใช่เครื่องจักร ไม่ว่าเราจะรอบคอบเพียงใด แต่มันเป็นเรื่องธรรมดาที่จะมีความผิดพลาดเกิดขึ้น ต่อให้เป็นการทำงานที่มีความซ้ำซากก็ตาม แต่ NLP จะไม่มีการทำงานผิดพลาด ตราบใดที่คุณตั้งค่า และฝึกฝนมันจนสมบูรณ์แล้ว มันพร้อมทำงานตลอด 24 ชั่วโมง โดยไม่มีวันเหนื่อยล้า ซึ่งเป็นสาเหตุหลักที่ส่งผลให้มนุษย์ทำพลาด นั่นทำให้คุณลดอัตราการจ้างคนไปได้หลายตำแหน่ง ช่วยลดต้นทุนทรัพยากรมนุษย์ในองค์กรได้เยอะมาก

เพิ่มความพึงพอใจให้ลูกค้า

ปัจจุบันนี้มีเครื่องมือ NLP สำหรับบริหารงานลูกค้าสัมพันธ์ให้เลือกใช้เพียบ มันสามารถตอบคำถามของลูกค้าได้แบบ 24/7 พร้อมดำเนินการส่งเรื่องต่อไปยังเจ้าหน้าที่ หรือแผนกที่รับผิดชอบได้อย่างเหมาะสม โดยที่ลูกค้าไม่ต้องรอแอดมินมาตอบในเวลาทำการ

ข้อเสียของ Natural Language Processing (NLP)

ยังไม่สามารถแยกแยะประโยคที่คล้ายกันได้

มีหลายคำที่ออกเสียงคล้ายกัน แต่มีความหมายแตกต่างกัน อย่างเช่น "I-Scream" กับ "Ice-Cream" เป็นต้น แม้ NLP ในปัจจุบันนี้จะมีความฉลาดมาก แต่หลายครั้งมันก็ยังมีปัญหาในการแยกแยะคำในลักษณะนี้อยู่บ้าง และมันส่งผลต่อการใช้งานบางอย่าง เช่น แอปแปลภาษา และการพิมพ์ด้วยเสียง

การเสียดสี

ในการสนทนาระหว่างมนุษย์ บ่อยครั้งที่เราจะมีการเล่นมุก ซึ่งบางมุกจะมีใช้การเสียดสี ประชดประชัน แต่สิ่งนี้เป็นความท้าทายของ NLP อย่างมาก มันยากที่จะให้ระบบเข้าใจว่ามันเป็นมุกตลก ที่ไม่ได้สื่อความหมายตามรูปประโยคโดยตรง

ยังไม่ครอบคลุมทุกภาษา

การพัฒนา NLP นั้น เป็นเรื่องของภาษา สำหรับภาษาที่ได้รับความนิยมใช้งาน ถือว่ามันพัฒนามาไกลมาก แต่ยังมีอีกหลายภาษาที่ยังไม่รองรับ หรือทำได้ไม่ดีเท่าไหร่นัก เมื่อเทียบกับภาษาหลัก และเป็นเรื่องยากที่จะทำให้ NLP สามารถใช้งานได้ทุกภาษาด้วย ยกตัวอย่างที่เงื่อนไขมีความยากก็อย่างทวีปแอฟริกาเพียงทวีปเดียว ก็มีภาษาที่คนท้องถิ่นใช้กันมากถึง 2,000 ภาษา หรือประเทศไนจีเรียก็มีภาษาท้องถิ่นใช้งานกันมากถึง 500 ภาษา เลยทีเดียว ถึงแม้จะมีคนพยายามฝึกโมเดล NLP ให้เข้าใจภาษาเหล่านี้ มันก็ไม่มีข้อมูลมากพอให้วิจัยอยู่ดี

หวังว่าเพื่อน ๆ จะเข้าใจ เทคโนโลยี Natural Language Processing (NLP) กันมากขึ้นแล้วนะครับ อย่างไรก็ตาม ถึงสถานการณ์ของ NLP ในปัจจุบันนี้จะดูเหมือนว่ามันมีความฉลาดที่น่าทึ่ง แต่มันก็ยังคงเป็นเทคโนโลยีที่ยังอยู่ในระหว่างการพัฒนาให้สมบูรณ์มากกว่านี้ ทั้งในแง่ของความสามารถ และจริยธรรมในการใช้งาน

ที่มา : www.ibm.com , www.techtarget.com , www.oracle.com , www.coursera.org , en.wikipedia.org , medium.com , www.kolena.com , www.elastic.co , www.talkie.se , www.wesuggestsoftware.com

คำสำคัญ »

คำสำคัญ »

|

|

แอดมินสายเปื่อย ชอบลองอะไรใหม่ไปเรื่อยๆ รักแมว และเสียงเพลงเป็นพิเศษ |

ทิปส์ไอทีที่เกี่ยวข้อง

แสดงความคิดเห็น

ซอฟต์แวร์

ซอฟต์แวร์ แอปพลิเคชันบนมือถือ

แอปพลิเคชันบนมือถือ เช็คความเร็วเน็ต (Speedtest)

เช็คความเร็วเน็ต (Speedtest) เช็คไอพี (Check IP)

เช็คไอพี (Check IP) เช็คเลขพัสดุ

เช็คเลขพัสดุ สุ่มออนไลน์

สุ่มออนไลน์