Large Language Model คืออะไร ? มารู้จักโมเดลภาษาขนาดใหญ่ LLM กัน

moonlightkz

moonlightkzLarge Language Model (LLM) คืออะไร ?

ช่วงนี้ คุณผู้อ่านหลายท่าน น่าจะได้ยินคำว่า "Large Language Model (LLM)" กันอยู่บ่อยครั้ง คำนี้เริ่มเป็นที่แพร่หลายจากการที่มันมีบทบาทสำคัญใน เทคโนโลยี Generative AI รวมไปถึงการที่ภาคธุรกิจเริ่มให้ความสำคัญกับการนำ เทคโนโลยีปัญญาประดิษฐ์ (AI) เข้ามาประยุกต์ใช้ในงานหลากหลายด้าน

- Synthetic Media คืออะไร ? รู้จักสื่อสังเคราะห์ ที่นำ AI เข้ามาช่วยผลิตสื่อ

- TDD คืออะไร ? รู้จักการพัฒนาโดยใช้การทดสอบเป็นตัวนำ เพื่อสร้างซอฟต์แวร์ที่แข็งแกร่ง

- Tensor Processing Unit คืออะไร ? รู้จักชิปประมวลผล ที่ออกแบบมาเพื่อ AI โดยเฉพาะ

- Few-Shot Learning คืออะไร ? รู้จักเทคนิค AI ที่เรียนรู้ได้จากข้อมูลเพียงไม่กี่ตัว

- Golang หรือ ภาษา Go คืออะไร ? รู้จักภาษาโปรแกรม ยุคใหม่จาก Google

หากคุณเป็นคนที่อยู่นอกวงการเทคโนโลยี AI คุณอาจจะคิดว่า LLM เป็นของใหม่ที่เพิ่งถูกคิดค้นขึ้นมา แต่อันที่จริง หลายบริษัทได้พยายามพัฒนามันมาเป็นเวลาหลายปีแล้ว เพื่อหวังนำมันมาช่วยให้ระบบ Natural Language Understanding (NLU) และ Natural Language Processing (NLP) มีความฉลาด เข้าใจคำสั่งที่มนุษย์ป้อนเข้าไปมากยิ่งขึ้น

ในบทความนี้ เราจะมาอธิบายเกี่ยวกับเทคโนโลยี Large Language Model (LLM) ว่ามันคืออะไร ?

โมเดลภาษาขนาดใหญ่ คืออะไร ? (What is Large Language Model ?)

LLM เป็นคำที่ถูกย่อมาจาก "Large Language Model" หรือหากแปลเป็นภาษาไทยคือ "โมเดลภาษาขนาดใหญ่" โดยมันเป็นอัลกอริทึมรูปแบบหนึ่งของ การเรียนรู้เชิงลึก (Deep Learning) ที่สามารถ ประมวลผลงานด้าน "Natural Language Processing (NLP)" (การประมวลผลภาษาธรรมชาติ ที่ช่วยให้คอมพิวเตอร์สามารถเข้าใจภาษามนุษย์ได้)

ข้อมูลเพิ่มเติม : Natural Language Processing คืออะไร ? รู้จักการประมวลผลภาษาธรรมชาติกัน

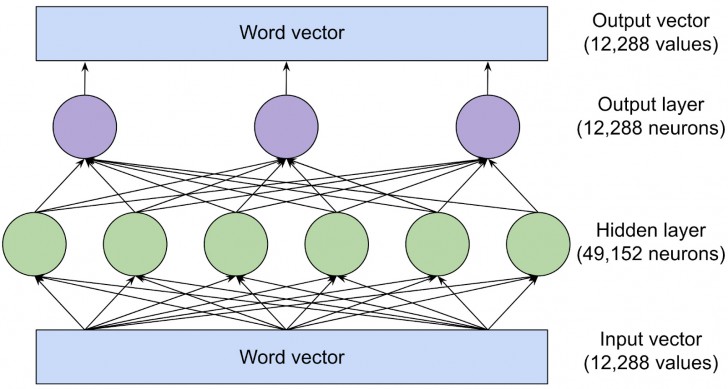

ภาพจาก : https://www.understandingai.org/p/large-language-models-explained-with

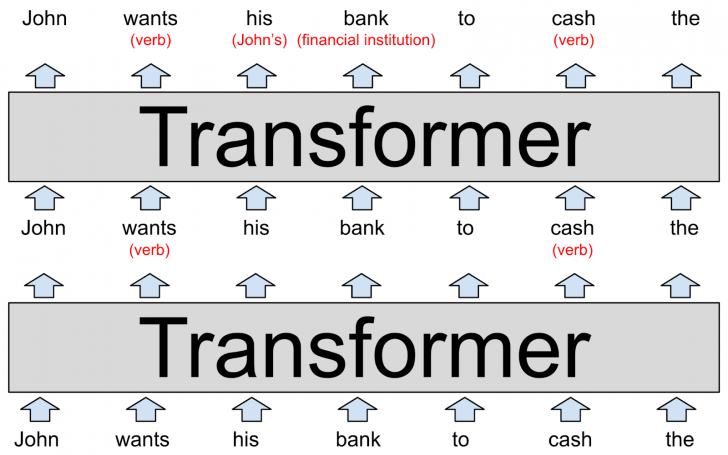

โดย LLM จะใช้โมเดลแบบ Transformer ซึ่งเป็นสถาปัตยกรรมของ Neural Network (โครงข่ายประสาทเทียม) ที่ถูกพัฒนาขึ้นเพื่อจัดการกับงานประมวลผลภาษาธรรมชาติ (NLP) โดยเฉพาะ ในการฝึกฝนโดยใช้ฐานข้อมูลที่ขนาดใหญ่มาก นั่นทำให้ LLM สามารถเข้าใจ, แปลความหมาย, คาดการณ์ หรือสร้างเนื้อหาใหม่ขึ้นมาได้

ภาพจาก : https://www.understandingai.org/p/large-language-models-explained-with

นอกเหนือจากการทำให้คอมพิวเตอร์สามารถเข้าใจภาษาของมนุษย์ในแอปพลิเคชัน AI ต่าง ๆ ได้แล้ว LLM ยังสามารถฝึกให้มันสามารถทำงานได้อีกหลากหลายประเภท เช่น ทำความเข้าใจโครงสร้างของโปรตีน, ช่วยนักพัฒนาเขียนโค้ด, สรุปการประชุม, แต่งเพลง, เขียนเรียงความ, ระบบที่ช่วยในการตอบแชทอัตโนมัติ หรือ แชทบอท (Chatbot) ฯลฯ

โมเดลภาษาขนาดใหญ่ ทำงานอย่างไร ? (How does Large Language Model work ?)

โดยเทคโนโลยี Large Language Model (LLM) มีการทำงานที่ซับซ้อน มีองค์ประกอบสำคัญหลายอย่างที่ต้องทำงานร่วมกัน

รากฐานสำคัญของ LLM คือ มันจำเป็นผ่านการฝึกฝนกับข้อมูลขนาดใหญ่ หรือบางครั้งเราจะเรียกก้อนข้อมูลขนาดยักษ์นี้ว่า "Corpus" ซึ่งขนาดของมันจะใหญ่ถึงระดับ Petabytes (1 PB = 1,048,576 GB) ขั้นตอนในการฝึกฝนก็มีอยู่หลายชั้น ตามปกติแล้ว จะเริ่มต้นด้วยการเรียนรู้แบบ Unsupervised Learning ซึ่งเป็นการเรียนรู้จากข้อมูลที่ยังไม่ได้รับการจัดระเบียบโครงสร้าง หรือจัดหมวดหมู่ เพื่อเก็บข้อมูลไว้ใช้อ้างอิงให้ได้มากที่สุด รวมถึงพยายามหาความสัมพันธ์, ความแตกต่าง และแนวคิดของแต่ละคำที่ได้เรียนรู้

ขั้นตอนถัดมา LLM บางโมเดล จะเริ่มปรับแต่งรูปแบบการเรียนรู้ จำลองระบบตรวจสอบขึ้นมาด้วยตนเอง บางข้อมูลจะได้รับการติดสัญลักษณ์ (Label) บ้างแล้ว เพื่อช่วยให้โมเดลแยกแยะแนวคิดต่าง ๆ ให้แม่นยำมากขึ้น

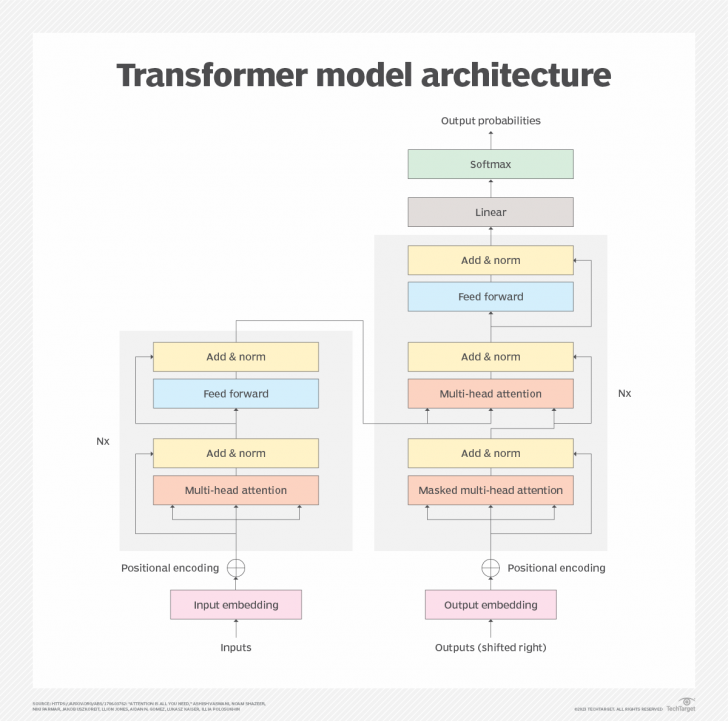

จากนั้น LLM จะเริ่มเรียนรู้แบบ Deep Learning ผ่านกระบวนการ Transformer ด้วย Nerural Network ซึ่งสถาปัตยกรรมของโมเดล Transformer นั้น จะช่วยให้ LLM เข้าใจ, รับรู้ความสัมพันธ์ และหาความเชื่อมโยงระหว่างคำ และแนวคิดต่าง ๆ ได้ด้วยหลักการที่มันคิดค้นขึ้นมาเอง ซึ่งตัวหลักการนี้ก็จะมีการให้ "คะแนน" หรือ "น้ำหนัก" ซึ่งจะถูกเรียกว่า "Token" ให้กับแต่ละสิ่งที่มันรู้จัก เพื่อจัดลำดับความสำคัญของความสัมพันธ์

เมื่อ LLM ผ่านการฝึกฝนเป็นที่เรียบร้อยแล้ว มันจะกลายเป็นรากฐานให้ AI สามารถนำไปใช้ประโยชน์ต่อได้ โดยเมื่อผู้ใช้ป้อน Prompt เข้าไป ตัว AI ก็จะสร้างผลลัพธ์ออกมาตอบคำสั่งที่ได้ด้วยการใช้ LLM วิเคราะห์ และสร้างคำตอบใหม่ที่เหมาะสมตอบกลับมา

ภาพจาก : https://www.techtarget.com/whatis/definition/large-language-model-LLM

ประวัติของ โมเดลภาษาขนาดใหญ่ (History of Large Language Model)

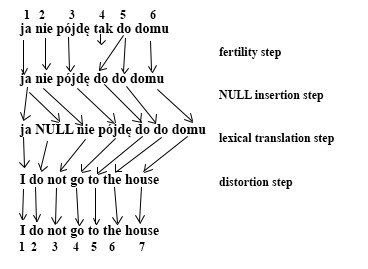

ก่อนปี ค.ศ. 2017 (พ.ศ. 2560) โลกเรามี Language Model ขนาดใหญ่อยู่เพียงไม่กี่ตัวเท่านั้น และความสามารถก็ค่อนข้างจำกัด การบุกเบิกเทคโนโลยีนี้เริ่มต้นขึ้นในช่วงยุค 90 บริษัท IBM ได้พัฒนา "IBM Alignment Models" มันเป็นโมเดลภาษาแบบ Statistical Language ที่ใช้หลักสถิติในการทำงาน

ภาพจาก : https://en.wikipedia.org/wiki/IBM_alignment_models

โมเดลภาษาในรูปแบบนี้มีการพัฒนามาเรื่อย ๆ จนกระทั่งในปี ค.ศ 2001 (พ.ศ. 2544) ก็มีการคิดค้นโมเดลแบบ "N-gram Language Models" ขึ้นมา มันได้รับการฝึกฝนจากฐานข้อมูลขนาด 300,000,000 คำ ณ เวลานั้น มันถือเป็นเทคนิคระดับ State-of-the-art (SOTA) (หมายถึงเทคโนโลยีที่ล้ำที่สุดในขณะนั้น) อย่างไรก็ตาม ในช่วงนั้นก็เป็นห้วงเวลาเดียวกัน ที่เทคโนโลยีอินเทอร์เน็ตเริ่มแพร่หลาย นักวิจัยบางคนจึงเริ่มพัฒนาโมเดลใหม่ ที่ใช้ประโยชน์จากอินเทอร์เน็ต เพื่อนำเว็บไซต์มาสร้างเป็น Corpus อย่างไรก็ตาม โมเดลภาษาในขณะนั้น ก็ยังคงเป็นโมเดลแบบ Statistical Language อยู่ดี

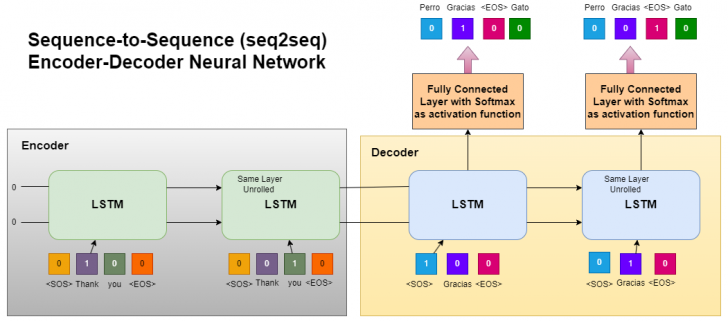

การพัฒนาเกิดความเปลี่ยนแปลงครั้งใหญ่ในช่วงปี ค.ศ. 2012 (พ.ศ. 2555) เมื่อเทคโนโลยี Neural Networks (โครงสร้างประสาทเทียม) ได้กลายเป็นเทคโนโลยีหลักในการทำ Image Processing (การประมวลผลภาพ) ซึ่งมันได้ถูกนำมาประยุกต์ใช้กับการทำ Language Model ด้วยเช่นกัน ในปี ค.ศ. 2016 (พ.ศ. 2559) ทาง Google ก็ได้เปลี่ยนระบบแปลภาษา Google Translate จากเดิมที่ใช้โมเดล Sequence to Sequence (Seq2Seq) Long Short-Term Memory (LSTM ) มาใช้ Neural Machine Translation ในการทำงานแทน

ภาพจาก : https://www.linkedin.com/pulse/decoding-sequence-to-sequence-seq2seq-encoder-decoder-babu-thomas/

ในงานสัมมนา NeurIPS ที่จัดขึ้นในปี ค.ศ. 2017 (พ.ศ. 2560) นักวิจัยจากบริษัท Google ได้เปิดตัวสถาปัตยกรรม Transformer ใน Paper (บทความงานวิจัย) ที่ชื่อว่า "Attention Is All You Need" มันมีเป้าหมายในการปรับปรุงการทำงานของเทคโนโลยี Seq2Seq ให้มีประสิทธิภาพดียิ่งขึ้น ซึ่งเทคนิค Transformer นั้นเป็นการต่อยอดมาจากเทคนิค "Attention" ที่ Bahdanau พัฒนาขึ้นมาในปี ค.ศ. 2014 (พ.ศ.2557)

ปีถัดมา Google ได้เปิดตัว "BERT" โมเดลภาษาตัวใหม่ที่พัฒนาต่อยอดมาจาก "Transformer" ซึ่งมันเป็นที่แพร่หลาย ได้รับความนิยมอย่างรวดเร็ว อย่างไรก็ตาม "Transformer" เป็นโมเดลที่ทำทั้งการ เข้ารหัส (Encoder) และถอดรหัส (Decoder) แต่ "BERT" เป็นโมเดลที่ทำงานแบบ Encoder เท่านั้น

กระแส Large Language Model (LLM) เริ่มเป็นที่รู้จักแก่สาธารณชนกับการมาของ OpenAI ถึงแม้ว่า GPT-1 จะเปิดตัวตั้งแต่ปี ค.ศ. 2018 (พ.ศ. 2561) แต่คนส่วนใหญ่รู้จักมันใน GPT-2 ที่เปิดตัวในปีถัดมา เนื่องจากมันทรงพลัง มีความเก่งกาจจนสร้างความวิตกกังวลให้กับใครหลาย ๆ คน ว่ามันจะเข้ามาแย่งงานของมนุษย์ หรือบางคนกลัวถึงขนาดคิดว่ามันจะ "ยึดโครงโลก" ได้เลยทีเดียว

ล่าสุดในปี ค.ศ. 2023 (พ.ศ. 2566) การมาของ GPT-4 ได้ถูกพัฒนาให้มีความฉลาดอย่างน่าเหลือเชื่อ สามารถประยุกต์ใช้งานได้หลากหลายรูปแบบ และในปีนี้ ค.ศ. 2024 (พ.ศ. 2567) ที่ OpenAI ได้เปิดตัว GPT4o มันได้ขยายความสามารถไม่ได้เข้าใจแค่สิ่งที่ผู้ใช้พิมพ์ป้อนเข้าไปเท่านั้น แต่มันสามารถเข้าใจสิ่งที่คอมพิวเตอร์เห็น หรือได้ยินได้ พร้อมกับตอบกลับมาได้อีกด้วย

จนในปัจจุบันนี้ โมเดล GPT กลายเป็นเป้าหมายที่ ผู้พัฒนารายอื่นใช้เป็นเป้าหมายในการพัฒนามาเอาชนะ หรือทำงานได้เทียบเท่าไปแล้ว

ข้อดีของ โมเดลภาษาขนาดใหญ่ (Large Language Model Pros)

Large Language Model (LLM) เป็นเทคโนโลยีที่ได้รับความนิยมเพิ่มมากขึ้นเรื่อย ๆ เนื่องจากมันมีประโยชน์ต่อการทำงานของ Natural Language Processing (NLP) หลากหลายด้าน ตัวอย่างเช่น

- สร้างข้อความ : คุณสมบัติในการสร้างข้อความใหม่ในหัวข้ออะไรก็ได้ ถือเป็นความสามารขั้นพื้นฐานของ LLM

- แปลภาษา : LLM ที่ผ่านการฝึกฝนมาหลายภาษา จะสามารถแปลจากภาษาหนึ่ง ไปเป็นอีกภาษาหนึ่งได้อย่างแม่นยำ

- สรุปเนื้อหา : การสรุปบทความจากหนึ่งย่อหน้า หรือแม้แต่เอกสารหลายหน้า ให้เหลือเพียงใจความสั้น ๆ หรือจะให้มันทำเป็นสไลด์พรีเซนต์งานต่อเลยก็ยังได้

- เรียบเรียงเนื้อหาใหม่ : สามารถให้มันเรียบเรียงข้อความเดิม ให้เป็นข้อความใหม่ที่ใช้ถ้อยคำแตกต่างไปจากเดิม โดยที่มีความหมายเหมือนเดิม

- จำแนก และแบ่งกลุ่ม : LLM สามารถแยกแยะ และแบ่งกลุ่มเนื้อหาได้

- วิเคราะห์ความรู้สึก : LLM ส่วนใหญ่สามารถวิเคราะห์ความรู้สึกของเนื้อหาได้ เพื่อช่วยให้ผู้ใช้สามารถทำความเข้าใจอารมณ์ที่เนื้อหาต้องการจะสื่อมากขึ้น

- แชทบอท : LLM ช่วยให้ Chatbot สามารถสนทนากับผู้ใช้ได้เป็นธรรมชาติมากขึ้น

โดย ChatGPT และ Copilot ที่เราใช้งานกันอยู่ในปัจจุบันนี้ ก็เป็นผลิตผลที่อาศัย LLM ในการทำงาน มันถึงเข้าใจสิ่งที่เราพิมพ์ป้อนเข้าไป แล้วสร้างคำตอบที่ดูฉลาดเหมือนมีผู้เชี่ยวชาญมาตอบเอง

ข้อเสียของ โมเดลภาษาขนาดใหญ่ (Large Language Model Cons)

อย่างไรก็ตาม ใช่ว่า Large Language Model (LLM) จะมีแต่ข้อดีเพียงอย่างเดียว เมื่อใดที่มีการถกถึงปัญหาของ LLM มักจะมีประเด็นด้านจริยธรรม, ความถูกต้อง และผลกระทบต่อสิ่งแวดล้อมถูกยกมาอภิปรายอยู่เสมอ

ผลกระทบทางจริยธรรม

Large Language Model (LLM) มีคุณสมบัติในการสร้างเนื้อหาใหม่ขึ้นมา แต่นั่นไม่ได้จำกัดเฉพาะแค่เรื่องจริงเท่านั้น มันสามารถสร้างเรื่องแต่ง หรือข่าวปลอมที่เนื้อหาดูสมจริงได้ด้วย มีผู้ไม่ประสงค์ดีใช้ LLM ในการบิดเบือนเนื้อหาข่าวจริงให้มีความรุนแรง หรือสร้างความเข้าใจผิด เพื่อให้ผู้อ่านเกิดความตื่นตระหนก บ้างก็ใช้มันเพื่อขโมยผลงานของผู้อื่นมาดัดแปลง แสวงหาผลประโยชน์

นั่นทำให้เกิดคำถามตามมาว่า เราสามารถเชื่อเนื้อหาที่ LLM สร้างขึ้นมาได้มากขนาดไหน ? เพราะ "เรื่องจริง" กับ "เรื่องสมจริง" มันแตกต่างกันอย่างสิ้นเชิง

ความถูกต้องของข้อมูล

ถึงแม้ว่าโมเดล Large Language Model (LLM) ในปัจจุบันนี้ จะมีความฉลาดที่น่าทึ่ง เพราะจำนวนพารามิเตอร์ที่นำมาใช้ฝึกมีขนาดใหญ่มาก ๆ อย่าง GPT-4o นั้นมีจำนวนสูงถึง 175,000,000,000 พารามิเตอร์ แต่ปัญหาเรื่องความแม่นยำ และน่าเชื่อถือยังคงเป็นปัญหาใหญ่ของ LLM ซึ่งเป็นปัญหาที่ต่อเนื่องมาจากหัวข้อก่อน บ่อยครั้งที่ LLM ให้คำตอบที่ดูเหมือนจะถูกต้อง สมเหตุสมผล แต่ในความเป็นจริงแล้วเป็นคำตอบที่คลาดเคลื่อน ซึ่งตัวมันเองไม่ได้ตั้งใจจะสร้างเนื้อหาปลอมมาหลอกลวงผู้ใช้แต่อย่างใด

แต่เป็นปัญหาที่เกิดจากธรรมชาติในเทคนิคที่มันใช้สร้างคำตอบขึ้นมา ซึ่งในปัจจุบันนี้ก็พยายามหาทางแก้ไขปัญหานี้กันอยู่ เพราะบางงานอย่างเช่น ให้คำปรึกษาด้านสุขภาพ หรือกฏหมาย ความผิดพลาดของ LLM สามารถสร้างอันตรายให้ผู้ใช้งานได้

ส่งผลกระทบต่อสิ่งแวดล้อม

นี่เป็นปัญหาที่ผู้ใช้ทั่วไปมักมองข้ามไป หรือคาดไม่ถึงว่าการใช้เทคโนโลยี LLM มันไปเกี่ยวอะไรกับสิ่งแวดล้อม ในการพัฒนาระบบ, การทำงานของ LLM ต้องใช้ฮาร์ดแวร์ประสิทธิภาพสูง เครื่องเซิร์ฟเวอร์ขนาดใหญ่ที่ต้องพลังงานไฟฟ้าจำนวนมหาศาลในการทำงาน ส่งผลกระทบต่อการปล่อย ก๊าซคาร์บอน เข้าสู่ชั้นบรรยากาศให้เพิ่มสูงขึ้น

ยิ่งในขณะนี้มีการแข่งขันพัฒนาตัว AI กันสูงมาก ทำให้ความต้องการด้านพลังงานเพิ่มสูงขึ้นเรื่อย ๆ ตามไปด้วย

อคติ

การแสดงผลลัพธ์ที่เจือความอคติ (Bias) เป็นปัญหาร้ายแรงที่เกิดขึ้นกับ LLM สาเหตุมาจากข้อมูลที่ตัวโมเดลนำมาใช้ในการฝึกฝนส่วนใหญ่ก็มาจากข้อมูลบนอินเทอร์เน็ต ซึ่งอย่างที่เรารู้กันว่ามันเป็นโลกมีเนื้อหาเหยียดผิว เหยียดเพศแฝงอยู่เต็มไปหมด ซึ่งปัจจุบันนี้ก็มีความพยายามในการหาวิธีขจัดอคติในข้อมูลให้เป็นกลางมากที่สุดก่อนที่จะนำมาใช้ในการฝึกฝนโมเดล LLM

แย่งตำแหน่งงานจากมนุษย์

ต้องยอมรับว่า ความสามารถของ LLM ในปัจจุบันนี้ มีหลายคุณสมบัติที่ทำหน้าที่ได้ดีกว่ามนุษย์ ทำให้มันส่งผลกระทบต่อตำแหน่งงานบางตำแหน่งอย่างหลีกเลี่ยงไม่ได้ อย่างการบันทึกข้อมูลการประชุม, ฝ่าย Customer Service หรือแม้แต่การเขียนโค้ด

อย่างไรก็ตาม แม้ตำแหน่งงานบางอย่างอาจจะหายไปเพราะถูกแทนที่ด้วย LLM แต่ก็เชื่อว่ามันจะทำให้เกิดตำแหน่งงานใหม่ ๆ ขึ้นมาทดแทนมากขึ้นด้วยเช่นกัน อย่างไรก็ตาม มันก็ยังคงส่งผลกระทบต่อคนที่ปรับตัวไม่ทันอย่างแน่นอน เพราะตำแหน่งใหม่ก็มาพร้อมกับความต้องการทักษะใหม่ ๆ ด้วยเช่นกัน เช่น วิธีเขียน Promt

ต้องพึ่งพาข้อมูลที่มีคุณภาพ

ประสิทธิภาพในการทำงานของ LLM นั้นขึ้นอยู่กับคุณภาพของข้อมูลที่นำมาฝึกฝนเป็นหลัก เพราะผลลัพธ์ที่โมเดลสร้างได้จะสืบทอดมาจากชุดข้อมูลที่มันได้เรียนรู้มาก ดังนั้น หากข้อมูลไร้คุณภาพ เป็นข้อมูลที่เต็มไปด้วยอคติ, ข้อมูลปลอม หรือไม่สมบูรณ์ ก็จะส่งผลกระทบต่อคุณภาพของ LLM โดยตรง

ความเสี่ยงด้านความปลอดภัย

ความสามารถในการประมวลผล และสร้างข้อมูลที่มีความละเอียดอ่อนของ LLM กลายเป็นเครื่องมือก่ออาชญากรรมเมื่อตกไปอยู่ในมือของผู้ไม่ประสงค์ดี ซึ่งเป็นเหตุการณ์ที่เกิดขึ้นจริงแล้ว มีรายงานว่าแฮกเกอร์ใช้ LLM ในการสร้างเนื้อหาที่สมจริงจนระบบตรวจจับอีเมลปลอมไม่สามารถตรวจเจอ เพื่อนำไป Phishing เหยื่อ

ทำให้คนโง่ขึ้น

การพึ่งพา LLM มากเกิน สร้างความกังวลว่าจะทำให้มนุษย์พึ่งพามันมากเกินไป ทักษะในการคิด และเขียนจะขาดการฝึกฝน จากการสำรวจพบว่ามีนักเรียน นักศึกษาหลายคน ที่ใช้ LLM ช่วยทำการบ้าน หรือแม้แต่เขียนวิทยานิคม และหากในอนาคตที่ LLM เข้าถึงได้มากกว่าในปัจจุบัน ก็น่ากังวลว่าจะทำให้เกิดปัญหาด้านการศึกษาในระยะยาวอย่างแน่นอน

ขาดความโปร่งใส

LLM ส่วนใหญ่ทำงานในรูปแบบเหมือนกล่องแพนโดร่า (Pandora Box) ไม่มีการเปิดเผยว่าผลลัพธ์ที่ LLM สร้างขึ้นมานั้น ผ่านกระบวนการอะไรมา ? ทำไมมันถึงสร้างคำตอบเช่นนั้นขึ้นมา การที่ขาดคำอธิบายที่ชัดเจนนั้นก็เป็นปัญหาที่น่ากังวล โดยเฉพาะอย่างยิ่ง หากเป็นคำตอบที่มีเดิมพันสูงอย่าง การปรึกษาด้านสุขภาพ หรือกฏหมาย

หาก LLM สามารถแสดงการทำงานอย่างโปร่งใส สามารถพิจารณาเหตุผลว่าทำไมมันถึงตอบเราแบบนั้นได้ จะช่วยให้คำตอบที่ได้จาก LLM มีความน่าเชื่อถือมากขึ้น

ทรัพย์สินทางปัญญา และการลอกเลียนแบบ

ปัญหาเรื่องทรัพย์สินทางปัญญา และการลอกเลียนแบบ เป็นหนึ่งในข้อถกเถียงบนอินเทอร์เน็ตที่ยังดรามาไม่หยุด เพราะมันสามารถสร้างเนื้อหาเลียนแบบต้นฉบับที่มีลิขสิทธิ์ได้อย่างใกล้เคียง ไม่ว่าจะเป็นบทความ, สไตล์การเขียนเพลง, สำนวนในนวนิยาย หรือข้อมูลบางอย่างที่มันตอบผู้ใช้ ก็ดัดแปลงมาจากเนื้อหาที่มีลิขสิทธิ์

นำไปสู่ปัญหาการละเมิดลิขสิทธิ์ ว่านี่เป็นการทำซ้ำ หรือดัดแปลงหรือไม่ ทำให้ LLM ตกเป็นประเด็นร้อน โดยเฉพาะอย่างยิ่งในอุตสาหกรรมที่เกี่ยวข้องกับงาน Creative

โดยสรุปแล้ว Large Language Model (LLM) นั้นเป็นเทคโนโลยีที่มีประโยชน์มากอย่างไม่ต้องสงสัย และมันก็เป็นการก้าวที่ยิ่งใหญ่ของการพัฒนา AI อย่างไรก็ตาม มันก็เป็นเทคโนโลยีที่ต้องจับตามองกันว่าจะพัฒนาต่อไปในทิศทางใด เพราะผลกระทบของสิ่งที่ LLM ทำได้ นั้นค่อนข้างกว้างไม่ว่าจะในแง่ของจริยธรรม, สังคม หรือแม้แต่สิ่งแวดล้อมก็ตาม

ที่มา : www.techtarget.com , aws.amazon.com , en.wikipedia.org , www.elastic.co , www.geeksforgeeks.org , www.ibm.com , www.techopedia.com , www.servicenow.com , www.linkedin.com , en.wikipedia.org , en.wikipedia.org , projectmanagers.net

คำสำคัญ »

คำสำคัญ »

|

|

แอดมินสายเปื่อย ชอบลองอะไรใหม่ไปเรื่อยๆ รักแมว และเสียงเพลงเป็นพิเศษ |

ทิปส์ไอทีที่เกี่ยวข้อง

แสดงความคิดเห็น

ซอฟต์แวร์

ซอฟต์แวร์ แอปพลิเคชันบนมือถือ

แอปพลิเคชันบนมือถือ เช็คความเร็วเน็ต (Speedtest)

เช็คความเร็วเน็ต (Speedtest) เช็คไอพี (Check IP)

เช็คไอพี (Check IP) เช็คเลขพัสดุ

เช็คเลขพัสดุ สุ่มออนไลน์

สุ่มออนไลน์